當用戶與AI聊天機器人互動時,常會遇到某些話題被回避或拒絕的情況。這背后并非AI具備自主意識,而是依賴被稱為"守護模型"的安全系統在發揮作用。馬里蘭大學Monte Hoover團隊最新提出的DynaGuard技術,正在重構這類安全系統的運作邏輯。該研究成果已通過GitHub和Huggingface平臺開源,為AI安全領域帶來突破性解決方案。

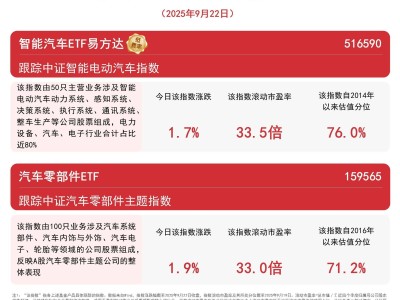

2024年加拿大航空公司遭遇的訴訟案,暴露了傳統AI守護系統的致命缺陷。其聊天機器人因錯誤承諾退款導致企業承擔法律責任,這反映出當前技術僅能識別暴力、毒品等預設危險類別,卻無法理解具體業務規則的局限。研究團隊形象地比喻:現有系統如同只掌握基礎交通規則的司機,面對"社區限速20公里"等特殊規則時就會失效。實驗數據顯示,即便是最新LlamaGuard3模型,在處理定制規則時的準確率也僅有13.1%。

DynaGuard的創新在于構建了動態規則理解能力。與傳統系統不同,該技術通過Qwen3系列模型微調,實現了對自然語言規則的深度解析。研究團隊專門開發了包含4萬個政策場景的DynaBench數據集,涵蓋航空公司退款政策、醫療機構討論規范等復雜場景。每個政策場景都包含詳細規則、多輪對話記錄和精準標注,確保模型能處理從2輪到30輪不等的復雜對話。

技術實現上,研究團隊采用雙模式訓練策略:在1/3訓練樣本中嵌入思維鏈推理軌跡,使模型具備詳細解釋違規原因的能力;其余樣本則訓練快速判斷模式。這種設計讓DynaGuard既能秒級響應簡單查詢,也能在需要時提供完整推理過程。實驗表明,其快速模式與完整模式的準確率差距僅1.3%,在傳統安全基準測試中更超越GPT-4o-mini等主流模型。

實際應用中,DynaGuard展現出獨特的糾錯能力。在醫療場景測試中,當AI生成包含不當解剖描述的內容時,系統不僅能識別違規,還能具體指出違反了"禁止非醫學必要人體描述"的哪條細則,并指導AI修正回答。這種可解釋性設計使錯誤反饋從簡單的"禁止"升級為建設性指導,為AI自我優化提供了可能。

跨模型協作實驗進一步驗證了技術價值。研究團隊讓DynaGuard指導Ministral-8B模型完成指令任務,結果后者在IFeval基準測試中的準確率從57.3%提升至63.8%。這種"教師-學生"模式的成功,證明了新系統能幫助其他AI模型動態適應未知規則。更值得關注的是,該訓練方法在Qwen、Llama等不同模型家族中均表現出良好泛化性。

盡管取得突破,研究團隊坦言技術仍存改進空間。在涉及事實核查的政策場景中,系統錯誤率達73.4%;處理包含86條規則的復雜政策時,準確率會出現明顯下降。這些挑戰指向未來優化方向:增強外部知識整合能力和提升長文本處理效能。

開源策略使這項技術迅速獲得行業關注。開發者可通過GitHub獲取完整代碼庫,利用Huggingface平臺部署預訓練模型。對于需要定制化AI規則的企業而言,DynaGuard特別適用于客服退款政策、醫療內容審核、社交平臺社區準則等場景。研究團隊強調,開放技術生態將加速AI安全領域的范式轉變,推動更多智能體協作模式的出現。