面壁智能與清華大學深圳國際研究生院人機語音交互實驗室(THUHCSI)聯合研發的語音生成基座模型VoxCPM正式開源,其參數規模僅為0.5B,已在GitHub、Hugging Face等平臺向全球開發者開放。這款端到端擴散自回歸模型突破了傳統語音合成技術路徑,通過融合層次化語言建模與局部擴散生成架構,實現了從文本到連續語音表征的高效轉換。

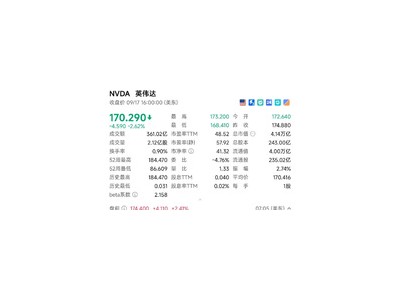

區別于CosyVoice、FireRedTTS等采用離散聲學詞元處理的方案,VoxCPM創新性地采用連續表征端到端TTS技術。該模型可直接解析輸入文本,實時流式生成高質量音頻片段,在單張NVIDIA RTX 4090顯卡上實現RTF≈0.17的推理速度。權威評測顯示,其在Seed-TTS-eval榜單的相似度、詞錯誤率等核心指標均達到行業頂尖水平。

模型具備強大的文本理解能力,可自主適配不同場景的語音特征。無論是模擬天氣預報員的規范播報、歷史英雄的激昂演講,還是還原方言主播的特色腔調,均能通過調整韻律參數實現精準還原。特別在中文處理方面,模型突破性地支持數學公式、特殊符號的語音合成,同時提供音素級標記替換功能,允許用戶自定義讀音修正。

技術團隊介紹,VoxCPM通過擴散生成機制與語言模型的深度耦合,顯著提升了語音輸出的自然度與穩定性。其流式輸出能力理論上支持無限長度音頻的實時生成,為智能客服、有聲讀物、教育輔導等場景提供了新的技術解決方案。目前開源版本已包含完整的訓練代碼與預訓練權重,開發者可基于現有框架進行二次開發。