百度于6月30日正式宣布,文心大模型4.5系列全面開源。此次開源涵蓋了多款模型,包括具備47B和3B激活參數的混合專家(MoE)模型,以及擁有0.3B參數的稠密型模型等,總計達10款。這些模型的預訓練權重與推理代碼均已實現完全開放,為開發者提供了豐富的資源。

文心大模型4.5系列現已在飛槳星河社區、HuggingFace等平臺上線,開發者可以方便地下載并部署這些模型。同時,百度智能云千帆大模型平臺也提供了開源模型的API服務,進一步拓寬了模型的應用場景。

早在今年2月,百度便預告了文心大模型4.5系列的即將推出,并確定了6月30日的開源日期。此次開源的模型在多個關鍵維度上均處于行業領先地位,包括獨立自研模型的數量占比、模型類型的多樣性、參數的豐富程度,以及開源的寬松度和可靠性。

文心大模型4.5系列在MoE架構上進行了創新,提出了一種多模態異構模型結構。這種結構適用于從大語言模型向多模態模型的持續預訓練,能夠在保持或提升文本任務性能的同時,顯著增強多模態理解能力。這一優越性能得益于多模態混合專家模型的預訓練技術、高效的訓練推理框架,以及針對模態的后訓練技術。

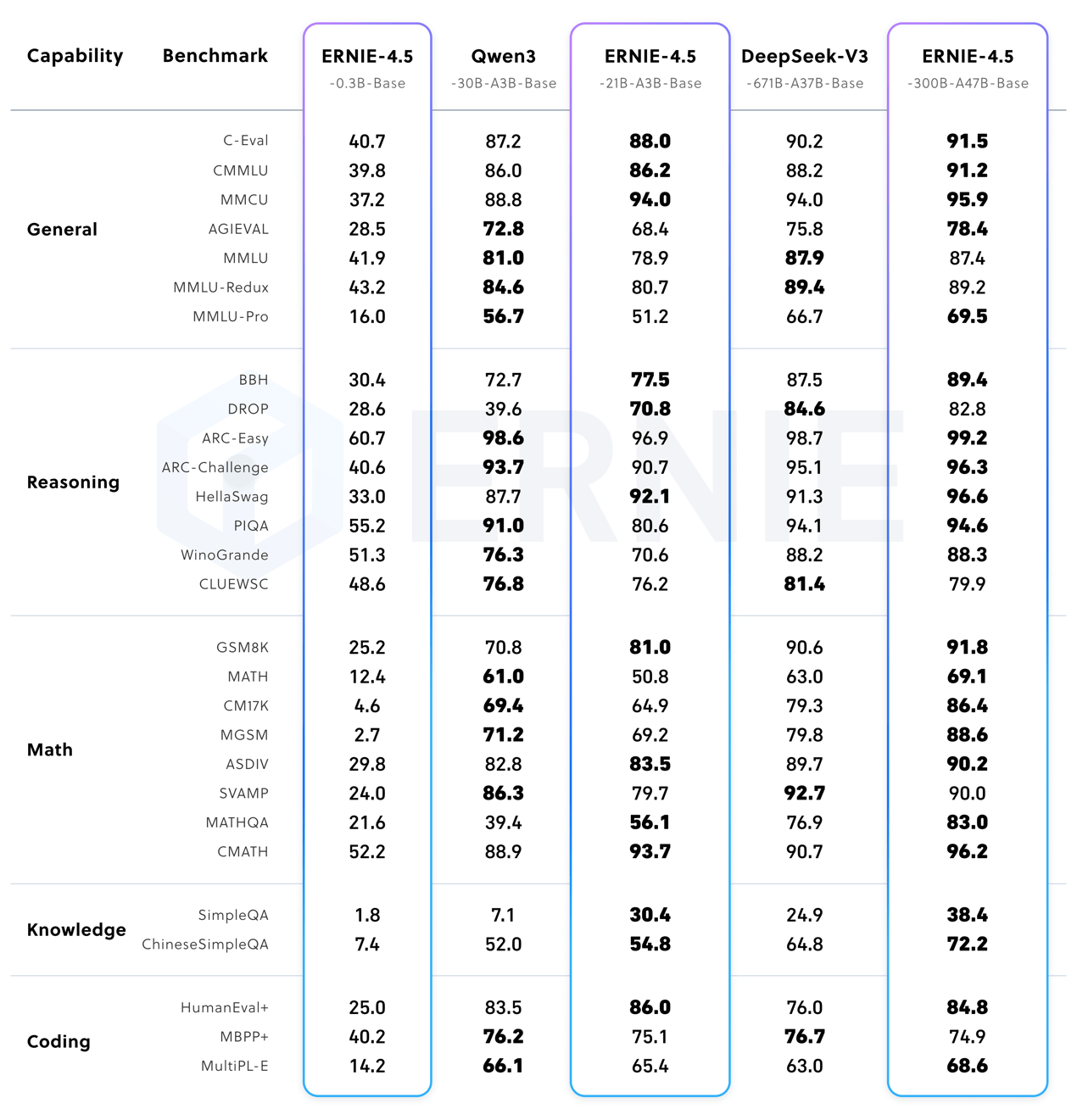

該系列模型均使用飛槳深度學習框架進行訓練和推理,效率顯著提升。在大語言模型的預訓練中,模型的FLOPs利用率達到了47%。實驗結果顯示,文心大模型4.5系列在多個文本和多模態基準測試中均達到了業界領先水平,特別是在指令遵循、世界知識記憶、視覺理解和多模態推理等任務上表現突出。

在文本模型方面,文心大模型4.5系列展現出了強大的基礎能力、高準確性的事實理解、出色的指令遵循能力,以及卓越的推理和編程能力。在多個主流基準評測中,該系列模型超越了DeepSeek-V3、Qwen3等模型。而在多模態模型方面,文心大模型4.5系列則擁有卓越的視覺感知能力和豐富的視覺常識,實現了思考與非思考的統一。在視覺常識、多模態推理、視覺感知等主流的多模態大模型評測中,該系列模型優于閉源的OpenAI模型。

文心4.5-21B-A3B-Base文本模型的效果與同量級的Qwen3相當,而文心4.5-VL-28B-A3B多模態模型則是目前同量級中最好的多模態開源模型,其性能甚至與更大參數的Qwen2.5-VL-32B模型不相上下。

文心大模型4.5系列的權重按照Apache 2.0協議進行開源,支持學術研究和產業應用。同時,基于飛槳提供的開源產業級開發套件,該系列模型能夠廣泛兼容多種芯片,降低了模型的后訓練和部署門檻。

作為國內AI研發的先行者,百度在算力、框架、模型到應用的全鏈條布局上構建了顯著的AI技術優勢。飛槳作為中國首個自主研發、功能全面的開源深度學習平臺,基于多年的技術和生態系統積累,此次同步升級發布了文心大模型開發套件ERNIEKit和大模型高效部署套件FastDeploy。這些工具為文心大模型4.5系列及開發者提供了即插即用的全流程支持。

值得注意的是,文心大模型4.5系列的開源標志著百度在框架層與模型層實現了“雙層開源”,為行業樹立了新的標桿。