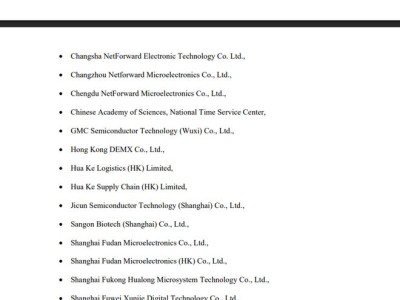

meta AI團隊近日正式推出MobileLLM-R1系列高效推理模型,標志著小參數語言模型進入全新發展階段。該系列包含140M、360M和950M三種參數規模的基礎模型及對應最終版本,專為數學計算、編程(Python/C++)和科學問題解決而設計,屬于監督微調(SFT)模型而非通用聊天模型。

研發團隊通過創新訓練方案顯著提升模型效率,950M參數版本僅使用約2T高質量token進行預訓練,總訓練量不足5T,卻在MATH、GSM8K、MMLU和LiveCodeBench等基準測試中展現出驚人性能。與使用36T token訓練的Qwen3 0.6B模型相比,該模型在各項指標上均達到同等水平甚至更優表現。在MATH基準測試中,950M模型的準確率是Olmo 1.24B模型的五倍,較SmolLM2 1.7B模型提升兩倍,編碼測試成績更是在開源模型中創下新高。

該系列模型的突破性進展引發機器學習領域廣泛關注。行業分析師指出,訓練成本的指數級下降與性能的指數級提升形成鮮明對比,這種"降本增效"模式正在重塑模型開發范式。通過優化token使用效率,研發團隊證明小參數模型同樣能實現復雜任務處理,為資源受限環境下的AI應用提供可行解決方案。

核心研發團隊由三位華人科學家領銜,其中Zechun Liu博士擔任項目首席研究員。這位復旦大學本科、香港科技大學博士畢業的研究者,在卡內基梅隆大學訪學期間師從AI領域頂尖教授,專注于模型量化與高效部署研究。Ernie Chang博士則帶來多模態學習領域的豐富經驗,其參與的"Agent-as-a-Judge"評估方法開創了模型評測新范式。團隊第三位成員Changsheng Zhao博士擁有北京大學與哥倫比亞大學雙重學術背景,在三星研究院工作期間積累的產業經驗,為其主導的極低比特量化研究提供實踐支撐。

技術文檔顯示,該系列模型架構經過特別優化,在保持輕量化的同時實現高效推理。研發團隊通過創新性的神經網絡設計,成功平衡模型復雜度與任務處理能力,這種設計哲學或將影響下一代端側AI模型的開發方向。隨著完整技術方案對外公開,學術界正圍繞其提出的token效率提升機制展開深入探討,多個研究團隊已啟動相關驗證實驗。