幾千人盲投,Kimi K2超越DeepSeek拿下全球開(kāi)源第一!

歪果網(wǎng)友們直接炸了,評(píng)論區(qū)秒變夸夸打卡現(xiàn)場(chǎng):

今天,競(jìng)技場(chǎng)終于更新了Kimi K2的排名情況——

開(kāi)源第一,總榜第五,而且緊追馬斯克Grok 4這樣的頂尖閉源模型。

并且各類單項(xiàng)能力也不差,能和一水兒閉源模型打得有來(lái)有回:

連續(xù)多輪對(duì)話并列第一,o3和Grok 4均為第四;編程能力第二,和GPT 4.5、Grok 4持平;應(yīng)對(duì)復(fù)雜提示詞能力第二,和o3、4o位于同一梯隊(duì);

甚至眼尖的朋友也發(fā)現(xiàn)了,唯二闖入總榜TOP 10的開(kāi)源模型都來(lái)自中國(guó)。(DeepSeek R1總榜第8)

當(dāng)然了,即使拋開(kāi)榜單不談,Kimi這款新模型過(guò)去一周也確實(shí)火熱——

K2過(guò)去一周真熱啊

公開(kāi)可查戰(zhàn)績(jī)包括但不限于下面這些:

從實(shí)打?qū)嵉臄?shù)據(jù)來(lái)看,發(fā)布這一周里,Kimi K2在開(kāi)源社區(qū)就獲得了相當(dāng)關(guān)注度和下載量。

GitHub標(biāo)星5.6K,Hugging Face下載量近10萬(wàn),這還不算它在中國(guó)社區(qū)的應(yīng)用。

連AI搜索引擎明星創(chuàng)企Perplexity CEO也親自為它站臺(tái),并透露:

Kimi K2在內(nèi)部評(píng)估中表現(xiàn)出色,Perplexity計(jì)劃接下來(lái)基于K2模型進(jìn)行后訓(xùn)練。

甚至由于訪問(wèn)的用戶太多了,逼得Kimi官方也出來(lái)發(fā)公告:

訪問(wèn)量大+模型體積大,導(dǎo)致API過(guò)慢。

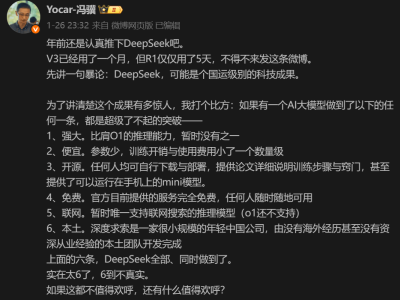

不過(guò)就在一片向好之時(shí),人們關(guān)于“Kimi K2采用了DeepSeek V3架構(gòu)”的質(zhì)疑聲再度升溫。

對(duì)此,我們也找到了Kimi團(tuán)隊(duì)成員關(guān)于K2架構(gòu)的相關(guān)回應(yīng)。

總結(jié)下來(lái)就是,確實(shí)繼承了DeepSeek V3的架構(gòu),不過(guò)后續(xù)還有一系列參數(shù)調(diào)整。

p.s. 以下分享均來(lái)自知乎@劉少偉,內(nèi)容經(jīng)概括總結(jié)如下~

一開(kāi)始,他們嘗試了各種架構(gòu)方案,結(jié)果發(fā)現(xiàn)V3架構(gòu)是最能打的(其他頂多旗鼓相當(dāng))。

所以問(wèn)題就變成了,要不要為了不同而不同?

經(jīng)過(guò)深思熟慮,團(tuán)隊(duì)給出了否定答案。理由有兩點(diǎn):

一是V3架構(gòu)珠玉在前且已經(jīng)經(jīng)過(guò)大規(guī)模驗(yàn)證,沒(méi)必要強(qiáng)行“標(biāo)新立異”;二是自己和DeepSeek一樣,訓(xùn)練和推理資源非常有限,而經(jīng)過(guò)評(píng)估V3架構(gòu)符合相關(guān)成本預(yù)算。

所以他們選擇了完全繼承V3架構(gòu),并引入適合自己的模型結(jié)構(gòu)參數(shù)。

具體而言,K2的結(jié)構(gòu)參數(shù)改動(dòng)有四點(diǎn):

增加專家數(shù)量:團(tuán)隊(duì)驗(yàn)證了在激活參數(shù)量不變的情況下,MoE總參數(shù)增加仍有益于loss下降。注意力頭head數(shù)減半:減少head數(shù)節(jié)省的成本,剛好抵消MoE參數(shù)變大帶來(lái)的開(kāi)銷,且效果影響很小。只保留第一層Dense:只保留第一層為dense,其余都用MoE,結(jié)果對(duì)推理幾乎無(wú)影響。專家無(wú)分組:通過(guò)自由路由+動(dòng)態(tài)重排(EPLB)可以應(yīng)對(duì)負(fù)載不均衡,同時(shí)讓專家組合更靈活,模型能力更強(qiáng)。

最終得到的推理方案就是,在相同專家數(shù)量下:

雖然總參數(shù)增大到1.5倍,但除去通信部分,理論的prefill和decode耗時(shí)都更小。即使考慮與通信overlap等復(fù)雜因素,這個(gè)方案也不會(huì)比V3有顯著的成本增加。

就是說(shuō),這是一種更“精打細(xì)算”的結(jié)構(gòu)調(diào)優(yōu)。

而且這種放棄自己的模型架構(gòu)路線,徹底走DeepSeek路線的做法,也被國(guó)內(nèi)網(wǎng)友評(píng)價(jià)為“相當(dāng)大膽”。

OK,以上關(guān)于Kimi和DeepSeek架構(gòu)之爭(zhēng)的問(wèn)題落定后,我們?cè)侔涯抗饫氐竭@次最新排名。

開(kāi)源追平or超越閉源ing

一個(gè)很明顯的趨勢(shì)是:「開(kāi)源=性能弱」的刻板印象正在被打破,開(kāi)源模型已經(jīng)越來(lái)越厲害了。

不僅榜單上的整體排名在上升,而且分?jǐn)?shù)差距也越來(lái)越小。

仔細(xì)看,模型TOP 10總分均為1400+,開(kāi)源和閉源幾乎可以看成位于同一起跑線。

而且這次拿下開(kāi)源第一的Kimi K2,總分已經(jīng)非常接近Grok 4、GPT 4.5等頂尖閉源模型了。

換句話說(shuō),以前我們可能還要在模型能力和成本之間作取舍,但隨著開(kāi)源力量的崛起,多思考一秒鐘都是對(duì)開(kāi)源的不尊重(doge)。

與此同時(shí),越來(lái)越多的行業(yè)人士也表達(dá)了對(duì)開(kāi)源崛起的判斷。

艾倫人工智能研究所研究科學(xué)家Tim Dettmers表示:

開(kāi)源擊敗閉源將變得越來(lái)越普遍。

Perplexity CEO也多次在公開(kāi)場(chǎng)合表示:

開(kāi)源模型將在塑造AI能力的全球擴(kuò)散路徑中扮演重要角色。它們對(duì)于因地制宜地定制和本地化AI體驗(yàn)至關(guān)重要。

而在已經(jīng)逐漸崛起的開(kāi)源模型領(lǐng)域,TOP 10中唯二開(kāi)源、且都是國(guó)產(chǎn)模型的含金量還在上升。