近期,人工智能領域迎來了一次重大飛躍,以大型語言模型(LLMs)為驅動的新型自主智能體正在逐步改變我們對智能系統的認知。這些智能體不僅能夠感知環境輸入,還能進行復雜推理并采取行動,形成了一個持續的交互循環。與傳統AI系統相比,這種基于LLMs的智能體實現了從靜態到動態的范式轉變,它們擁有交互性和增強的記憶能力,使得AI的功能邊界得到了前所未有的拓展。

然而,這一轉變也伴隨著新的安全風險。由于自主智能體能夠在動態、開放式環境中執行多步任務,包括調用外部工具和修改數據庫等,因此它們面臨著記憶投毒、工具濫用、獎勵操控以及價值錯位導致的涌現性失配等多重威脅。這些風險遠遠超出了傳統AI系統或獨立LLMs的威脅模型范疇,對AI安全提出了新的挑戰。

為了應對這些挑戰,研究人員近年來提出了多種防御策略,涵蓋輸入凈化、記憶生命周期控制、受限決策制定、結構化工具調用以及內省式反思機制等方面。然而,這些策略大多是孤立實施的,缺乏跨模塊、跨時間維度的系統性響應能力,無法全面有效地應對智能體自主性增強帶來的安全風險。

鑒于此,一項名為“反思性風險感知智能體架構”(R2A2)的新方案應運而生。這一統一的認知框架基于受限馬爾可夫決策過程(CMDPs),融合了風險感知世界建模、元策略適應以及獎勵–風險聯合優化機制。R2A2旨在智能體的決策循環中實現系統化、前瞻性的安全保障,以確保智能體的行為始終與人類利益保持一致。

R2A2的提出,不僅標志著智能體自主性如何重塑智能系統的安全格局,也為下一代AI智能體的設計提供了理論藍圖。在這一藍圖中,安全性被視為核心設計原則,旨在通過構建準確、可解釋的世界模型,生成因果假設,并在不確定性下進行推理,從而降低目標錯配帶來的風險。

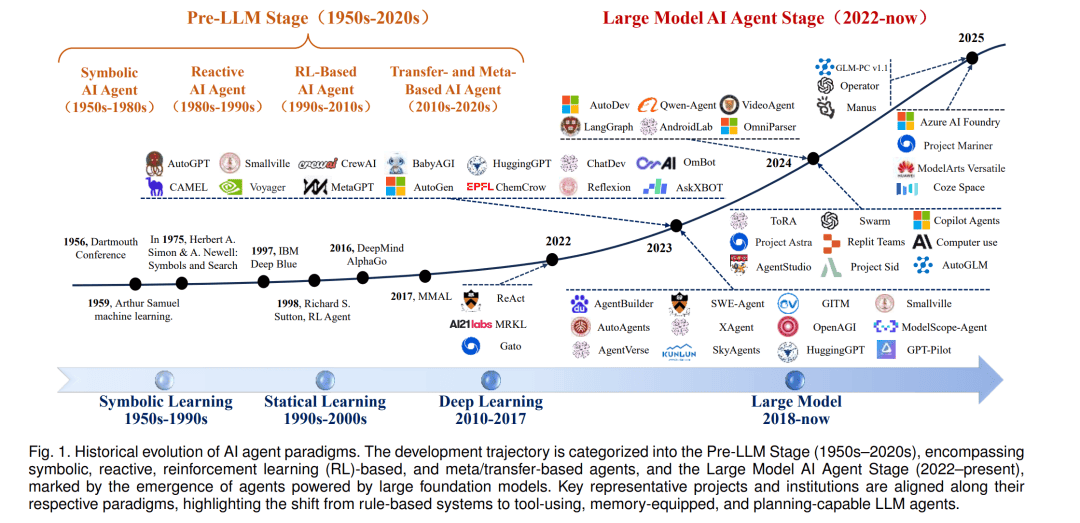

從靜態模型到基于LLMs的自主智能體,這一范式轉變帶來了顯著的變革。傳統AI系統通常依賴預定義規則或狹窄模型,難以泛化到預設范圍之外。而基于LLMs的智能體則繼承了底層模型的開放式問題解決能力,擁有更廣闊的行動空間。它們可以在運行時閱讀文檔或動態上下文,即興學會使用新工具,從而在社會中扮演通用助手的角色,解決各種復雜任務。

然而,這種高度自主性也帶來了前所未有的安全挑戰。自主智能體能夠執行真實世界中具有后果的行為,如執行代碼、修改數據庫等,從而放大了系統故障與對抗性攻擊的風險。因此,我們必須謹慎確保智能體的“對齊性”,即它們能夠可靠地追求有益目標、配合人類監督,并能容忍設計上的不完美。

為了系統性理解自主性增強如何帶來安全風險的升級,研究人員對三類AI系統的關鍵區別進行了總結與對比:傳統AI、獨立LLMs以及基于LLMs的自主智能體。這一對比涵蓋了自主性水平、學習動態、目標形成、外部影響、資源訪問能力與對齊可預測性等多個維度。通過這一結構化升級表,我們可以清晰地看到智能體架構漏洞與防御策略之間的關聯,為后續研究提供了基本視角。

隨著AI技術的不斷發展,基于LLMs的自主智能體將在各個領域發揮越來越重要的作用。然而,我們必須時刻警惕它們帶來的安全風險,并采取有效的防御策略來確保智能體的行為始終符合人類利益。R2A2架構的提出為我們提供了一個有力的工具,讓我們能夠在智能體的決策循環中實現系統化、前瞻性的安全保障,為AI技術的可持續發展奠定堅實基礎。