小鵬汽車近日在其新品發布會上宣布,將在其售價20萬左右的純電動車型上搭載高達2200+TOPS的算力,這一創舉在業內引起了廣泛關注與熱議。不少人對小鵬的技術實力表示贊嘆,認為這標志著智能駕駛技術的新里程碑。然而,也有質疑聲認為,通過3顆自研芯片堆砌出的高算力是否過于“奢侈”,并質疑這種算力堆疊的實際意義。

針對這些質疑,小鵬在發布會上已給出了明確回應:核心目標在于實現大模型的本地部署。這一戰略包含兩個關鍵點:一是大模型,二是本地部署。在AI時代,更大的模型往往意味著更強的能力,遵循Scaling Law定律,模型參數量越大,效果往往越好。

那么,什么樣的模型才能被稱為“大模型”呢?目前,受限于車規級芯片的算力,車端部署的模型通常經過輕量化處理,實際部署的模型參數量常在50億以下,如理想的VLA司機大模型僅為40億參數,尚稱不上“大”。相比之下,小鵬的自動駕駛云端基座模型已達到720億參數,這才是真正意義上的大模型,但受限于算力,無法在車端實現本地部署。

為了解決這一矛盾,小鵬選擇將大模型部署到車端,于是我們看到了3顆圖靈AI芯片組成的2200TOPS算力系統,最高可支持300億參數的模型。300億參數意味著什么?以小鵬的基座模型為例,從720億參數縮減到300億,可能只需進行結構化剪枝和MoE轉換,但從720億縮減到70億,則可能需要重構,性能差距顯著。

或許有人疑問,在5G時代,為何不使用云端大模型以降低車端算力需求?這涉及到了本地部署的必要性。對于LLM等應用,云端部署確實具有優勢,可以并行處理多個需求,降低成本。但行車模型對時延和幀數要求極高,云端部署難以滿足。何小鵬在發布會上提到,VLA模型至少需要達到每秒20幀才能保證足夠的行車能力,這意味著從感知到結果回傳的總耗時需在50毫秒內完成,云端部署難以實現。

即便解決了延遲通信問題,也難以完全避免網絡波動或通訊失效的風險,這可能導致車端系統降級甚至癱瘓,影響用戶體驗和行車安全。另一個關鍵點是全球化,本地部署無需聯網運行,避免了數據傳輸的合規問題,使得模型可以在全球范圍內快速部署。

綜合來看,大模型的本地部署被認為是車端智能駕駛的最優路線。小鵬雖然尚未激進地將基座模型直接搬上車,但已選擇將VLA+VLM模型部署到G7車型上。具體來說,G7使用2顆圖靈芯片(共1400+TOPS)運行VLA模型,另1顆圖靈芯片(700+TOPS)運行VLM模型,芯片間通過PCI-E通信。

這種分工基于小鵬對人腦功能的理解,認為車或機器人也應以能力對算力進行區分。VLA負責運動和決策,需要更大的算力以保證每秒20幀的性能;而VLM負責整車感知,如接收指令、識別路牌等,對算力需求相對較低。即便如此,本地部署的VLA+VLM也已展現出強大的想象空間,如小鵬在發布會上提到的“智駕能力比Max車型高10倍以上”等。

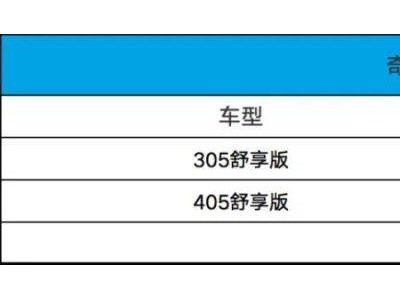

這一切的基礎,正是小鵬汽車所強調的大算力。隨著小鵬G7的全球首秀臨近,業界對這款車型充滿了期待。