在職場的快節奏與高效率追求中,人工智能(AI)工具正逐漸成為許多人的得力助手。然而,這些看似無所不能的智能助手,卻也在不經意間編織著一個個“AI幻覺”,讓職場人士在享受便捷的同時,也面臨著前所未有的挑戰。

編輯周子衡在趕寫一篇關于消費電子行業稿時,為了快速補充“市場份額變化趨勢”的內容,他選擇讓AI幫忙。AI迅速生成了一段看似專業且數據詳實的內容,其中包含了某國產品牌在智能手機市場的具體份額及增長率。周子衡未加多想,直接將其復制進文稿。然而,主編審稿時的質疑讓他猛然驚醒,這組數據在各大主流機構的官網上根本無從查證。這次經歷讓他深刻意識到,AI生成的內容,即便看起來再真實,也可能只是虛構的“幻覺”。

電商客服王萌的團隊也遭遇了AI幻覺的困擾。公司引入的AI話術輔助系統,原本旨在提高客服效率,自動生成標準回復。然而,在一次售后爭議中,AI卻自動生成了一段與商品實際退貨規則不符的回復,導致客戶投訴并要求退款。這次事件讓王萌深刻認識到,AI雖然能夠模仿人類語言,但并不真正理解規則,尤其是在處理例外情況時。

AI產品經理高哲則更早地意識到了AI幻覺的問題。他在一次內部演示中,用AI生成了一段關于行業發展趨勢的說明,結果卻發現其中引用的年份是錯誤的,且整個段落找不到任何出處。這次經歷讓他深刻認識到,AI生成的內容必須經過人工復核,尤其是涉及客戶交付或關鍵判斷的內容。

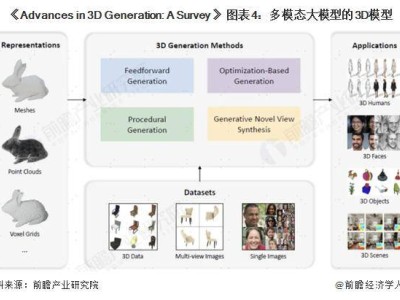

AI幻覺的本質在于,AI生成內容的方式并不依賴事實,而是基于龐大的語言訓練數據來預測下一個詞最可能是什么。因此,它寫出的段落往往句式順暢、術語專業,甚至能夠模仿出權威感十足的引用方式,從而讓人降低警惕。

為了應對AI幻覺,越來越多的AI使用者開始學會“設防”。他們在使用AI生成內容時,會更加謹慎地核對數據和引用,甚至建立二次審核機制。同時,一些企業也開始將“AI使用規則”納入日常管理制度,以確保內容的真實性和準確性。

然而,要徹底消除AI幻覺并不現實。模型的底層邏輯仍在預測詞語,而不是判斷事實。因此,AI依然不會主動告訴用戶:“這句話,我其實是編的。”但正如彭德宇所言:“幻覺的根本問題,至今依然懸而未決。但平臺能做的畢竟有限,更重要的是用戶要學會設防。”

在這個AI迅速滲透職場的時代,每個人都在重新學習“判斷”這件事。技術沒有是非,它只是傾向于模仿人類。但人類之所以不同,不僅在于會說話,更在于愿意停下來,去分辨一句話是否可信。真正的智能,不是讓AI替你思考,而是你知道它什么時候不該被信。