人工智能領域迎來重大突破,阿里巴巴Qwen團隊推出的Qwen3-VL視覺語言模型引發行業關注。這款模型突破傳統AI的局限,不僅能同時處理文字、圖像和視頻信息,還能理解長達25萬詞的文檔內容,甚至具備根據界面截圖生成代碼的實用能力。其核心優勢在于實現了真正意義上的多模態融合,讓AI像人類一樣自然地整合視覺與文本信息。

在技術架構層面,研究團隊創新性地設計了三大核心組件。增強版位置編碼技術通過交錯MRoPE機制,將時間、空間信息均勻混合處理,顯著提升視頻理解能力;DeepStack融合機制打破傳統視覺與語言模塊的獨立運作模式,實現多層次深度協作;基于文本的時間對齊技術采用簡潔的場景標簽系統,使模型能直觀把握視頻時間結構。這些創新使模型在處理復雜場景時展現出卓越的推理能力。

模型訓練體系采用四階段漸進式培養方案。初始階段通過670億圖文樣本建立基礎對應關系,隨后在1萬億詞匯的多模態數據中拓展能力邊界。第三階段專門強化長文本處理,將輸入長度擴展至32768詞,最終階段更是突破至256K詞匯量級。后訓練階段引入雙版本微調策略,非思維版本注重響應速度,思維版本則展示完整推理鏈條,滿足不同場景需求。

數據構建工程堪稱AI領域的"百科全書計劃"。研究團隊不僅重新撰寫了更精準的圖像描述,還構建了涵蓋13個語義類別的大規模知識庫。在OCR領域將支持語言從10種擴展至39種,文檔解析任務收集300萬份多語言PDF樣本。特別開發的自動化標注流水線,通過三級質量把控機制生成高精度物體標注數據,為模型訓練提供堅實基礎。

性能驗證顯示突破性成果。在MMStar測試中,2350億參數版本取得78.7分,與頂尖模型差距微小;MMBench測試中非推理模式以89.3分領跑。數學視覺推理領域表現尤為突出,在MathVista等測試中多次刷新紀錄。中等規模32B版本在多項基準測試中超越Gemini-2.5-Flash,展現卓越的規模效應。多語言OCR支持39種語言,其中32種語言準確率超70%。

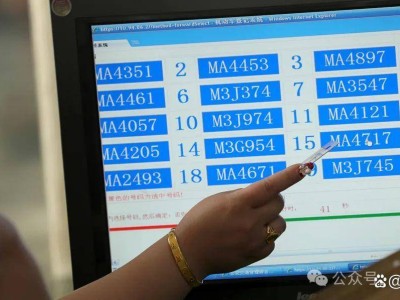

實際應用場景展現驚人潛力。在多圖像理解任務中,模型能同時分析多張監控畫面間的關聯性;空間理解測試中準確識別物體三維位置與功能屬性;視頻理解能力使80億參數版本達到前代720億參數模型的性能水平。智能代理測試中,320億參數版本在移動端界面操作任務取得63.7分,超越多數基礎模型。代碼生成能力支持從網頁截圖直接生成HTML/CSS,甚至能將流程圖轉化為可執行代碼。

技術影響力輻射整個AI生態。該模型重新定義了長文本處理標準,其256K上下文窗口在"針海撈針"測試中實現100%準確率,擴展至100萬token時仍保持99.5%精度。多版本架構設計提供靈活解決方案,從輕量級2B版本到旗艦級235B版本,滿足不同場景需求。研究團隊選擇開源策略,完整模型家族采用Apache 2.0協議發布,為全球開發者提供基礎技術支撐。

這項突破引發行業深度思考。超強代碼生成能力可能重塑軟件開發流程,文檔理解技術或將改變知識管理方式。研究團隊特別強調,模型在保持多模態優勢的同時,文本處理能力達到專業模型水準,這種均衡發展模式為通用人工智能研究提供新思路。完整技術細節已通過學術論文公開,為后續研究提供重要參考。