當手機拍攝的照片出現傾斜或文字模糊時,人們通常會本能地旋轉屏幕或放大圖像。然而,對于人工智能系統而言,這些看似簡單的操作卻構成重大挑戰。最新研究顯示,當前最先進的圖像識別模型在處理旋轉或翻轉后的圖片時,準確率可能暴跌超過80%,這種局限性嚴重制約了AI在真實場景中的應用價值。

浙江大學與字節跳動聯合團隊開發的CodeVision框架,通過賦予AI"動手"處理圖像的能力,成功突破這一瓶頸。該系統突破傳統AI被動接收輸入的模式,創新性地采用編程思維解決問題——當檢測到圖像方向異常時,AI會自動生成代碼調用旋轉工具;發現目標區域過小時,會編寫裁剪指令進行局部放大。這種將代碼作為通用接口的設計,使AI能夠靈活調用任何圖像處理功能,甚至組合多個工具解決復雜問題。

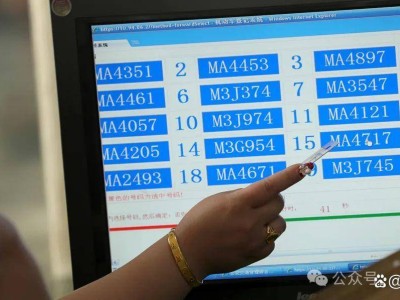

研究團隊構建的MVToolBench基準測試顯示,在需要多工具協作的任務中,CodeVision-7B模型得分達到60.1分,較第二名提升近一倍。在OCRBench數據集的180度旋轉測試中,基礎模型準確率僅58%,而經過訓練的同規模模型提升至73.1%;垂直翻轉場景下,基礎模型17%的準確率被提升至67.4%。這些數據印證了新框架在處理非標準圖像時的顯著優勢。

該系統的訓練過程融合監督學習與強化學習策略。初期通過5000個精心設計的案例,教授AI基礎工具使用方法,包括單工具操作、多工具組合及錯誤處理等場景。隨后采用強化學習優化策略選擇,其獎勵機制設計尤為精妙:不僅關注最終結果正確性,更獎勵工具使用的合理性。當圖像確實需要旋轉時,系統會強制要求使用旋轉工具才能獲得獎勵,防止AI通過投機方式獲取高分。

實驗表明,CodeVision展現出超越預期的涌現能力。在未接觸過的新工具面前,系統能自主探索其功能;面對復雜任務時,可創造性地將多個操作合并執行;當代碼執行失敗時,能分析錯誤信息并自動修正策略。這種自我優化機制,使AI在處理既需旋轉又需裁剪的復合任務時,能先編寫90度旋轉代碼,再精準定位目標區域進行裁剪,最終準確回答問題。

技術實現層面,研究團隊構建了安全的代碼執行沙盒,支持主流圖像處理庫如OpenCV、PIL的調用。模型架構基于Qwen2.5-VL系列改進,通過專項訓練實現視覺理解、代碼生成與工具調用的有機整合。訓練數據覆蓋手寫文字、野外OCR、表格圖表等多個領域,并開發自動驗證機制確保數據質量。強化學習階段采用的GRPO算法,通過比較8個不同解決方案的獎勵值,引導模型學習最優策略。

盡管取得突破,研究團隊也指出當前局限:工具類型仍集中于基礎圖像操作,未來需整合圖像生成、三維處理等更復雜功能;目標定位精度有待提升,模型有時會過度裁剪以確保包含目標;計算成本較傳統方法有所增加。針對評估基準,現有測試主要聚焦文本相關任務,后續需擴展至更多視覺推理場景。

這項技術已展現廣闊應用前景。在文檔處理領域,可自動糾正掃描文件的傾斜角度;教育場景中,能優化學生上傳的模糊作業圖片;醫療影像分析時,可自動調整CT片的對比度和方向。社交媒體平臺可利用該技術自動優化用戶上傳的圖片質量,工業檢測系統能動態適應生產線上的圖像變化,無人駕駛視覺模塊也可通過實時圖像優化提升環境感知能力。

CodeVision框架的突破性在于推動AI從被動感知向主動操作演進。這種轉變標志著AI系統開始具備類似人類的"元認知"能力——不僅知道如何思考,更懂得創造更好的思考條件。當AI學會通過調用工具優化自身工作環境時,其處理現實世界復雜問題的能力將實現質的飛躍,為通用人工智能的發展開辟新路徑。