在智能制造的浪潮中,人機協作已成為不可或缺的一環。然而,如何確保這一過程中人員的安全,始終是業界亟待解決的難題。近日,第二屆雄安未來之城場景匯雄安國際機器人大賽上,一個名為“數字孿生驅動的人機協作安全距離快速感知系統”的項目脫穎而出,為這一問題提供了創新性的解決方案。

該項目由北京郵電大學智能工程與自動化學院教授褚明帶領的團隊研發,憑借其超快的響應速度、無死角的安全防護以及低廉的部署成本,一舉奪得大賽一等獎。這一系統能夠在48毫秒內完成對潛在危險的感知與響應,是人類反應速度的兩倍多,真正實現了工業場景下人機協作的安全高效。

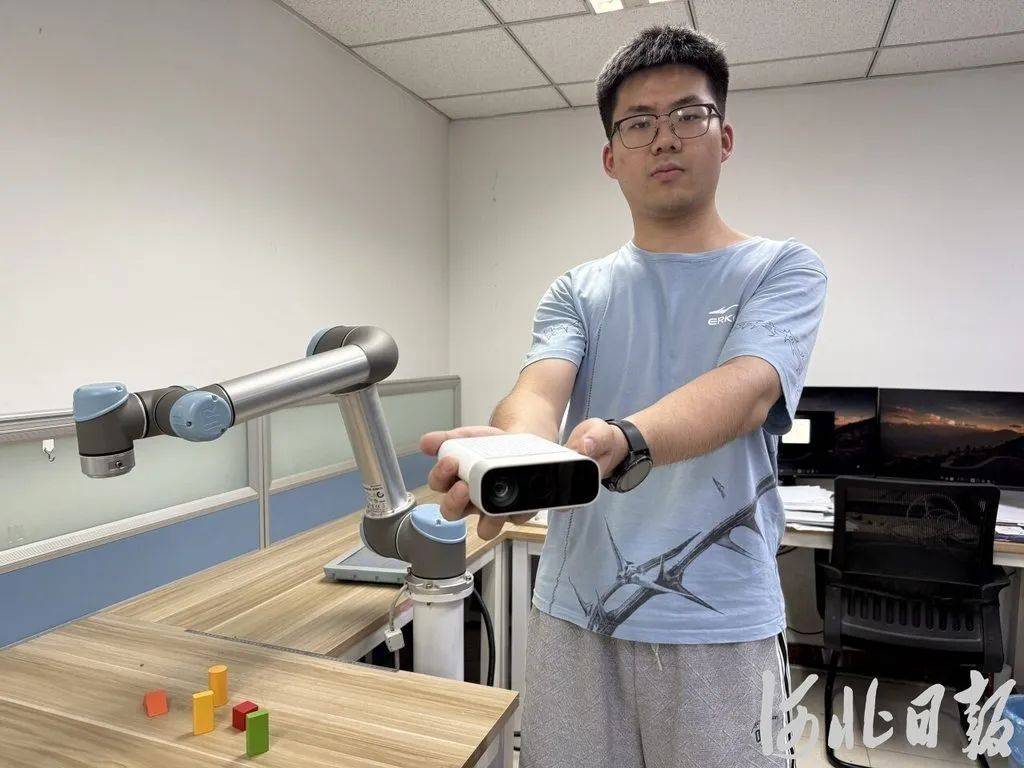

在褚明的實驗室里,六軸桌面式協同機械臂正在輕盈地舞動。但當有人靠近時,一旁的電腦屏幕上立刻浮現出人體的骨骼結構,并在人與機械臂之間生成一條明黃色的動態線條,實時測量并調整二者之間的距離。一旦距離過近,系統便會立即向機器人發出“停機”或“減速”的指令,從而有效避免可能發生的碰撞事故。

褚明教授解釋說,傳統的人機安全監測主要依賴于激光雷達、紅外和聲波測距等技術,但這些方法都存在明顯的缺陷。例如,激光雷達雖然能夠實現全向覆蓋,但響應速度慢且成本高昂;而聲波測距則只能測量到正面相對的區域,存在監測盲區。這些設備幾乎都需要外掛在機器人上,不僅影響工作的靈活性,甚至還可能帶來新的安全隱患。

為了克服這些挑戰,褚明團隊將數字孿生技術與計算機視覺深度融合,開發出了一套全新的安全感知系統。該系統僅需要一個紙抽大小的深度相機作為硬件設備,就能讓機器人在“零穿戴”的情況下擁有360度全場景視角。深度相機每秒能拍攝60幀畫面,通過識別人體32個骨骼關鍵點來構建動態骨骼框架,實現精準動作捕捉。在此基礎上,團隊進一步篩選出25個關鍵點,并利用工業機器人內置的光電碼盤傳感器重構機器人運動姿態,從而完成人和機器人的建模。

這種高度簡化的建模方式大大降低了系統數據計算量,為毫秒級實時響應提供了關鍵技術保障。同時,為了更真實地計算人體與機器人的安全距離,研究團隊還考慮到人的胖瘦對距離的影響,為數字模型穿上了一層“肌肉外衣”。經過反復試驗驗證,系統的距離測量誤差已經被嚴格控制在3.5%以內。

在采訪中,記者親身體驗了這一系統的安全防護能力。無論變換何種動作和距離,機械臂始終與記者保持著安全距離。電腦屏幕上那條不斷變換數據的明黃色線條,仿佛是一道無形的屏障,將人與機器人之間的潛在危險隔絕開來。

除了安全性能卓越外,該系統的部署也極其簡單便捷。它僅依賴深度相機和軟件模組運行,每個定焦深度相機可精準覆蓋6米遠范圍,單個監控區域的部署成本僅2萬元。這一優勢使得該系統在制造企業中備受歡迎,不少企業當場表達了合作意向。

褚明教授表示,他們希望通過這次大賽,讓這項技術接受市場的真實檢驗,并持續優化技術方案,推動實驗室成果走出象牙塔,真正服務實體經濟。同時,團隊在人機共存領域的研究仍在持續深化,他們正在研究從仿真到實體的相關課題,推動人機協作向更高層級發展。

在褚明看來,未來的人機協作將是一幅全新的圖景。機器人將不再是冰冷的執行者,而是能夠理解人的意圖、預判人的需求的智能伙伴。在這樣的場景下,人機協作將更加默契高效,共同推動智能制造的發展邁向新的高度。