7月2日消息,今天上午,智譜開放平臺產業生態大會在上海浦東張江科學會堂舉辦,開源發布新一代通用視覺語言模型GLM-4.1V-Thinking。

在智譜開放平臺產業生態大會上,智譜宣布浦東創投集團和張江集團對智譜總額10億元的戰略投資,并于近期完成首筆交割。同時,三方還啟動了一項合作,共同建設人工智能新型基礎設施。

智譜今日正式發布并開源視覺語言大模型GLM-4.1V-Thinking,這是一款支持圖像、視頻、文檔等多模態輸入的通用推理型大模型,專為復雜認知任務設計。

從官方獲悉,它在GLM-4V架構基礎上引入“思維鏈推理機制(Chain-of-Thought Reasoning)”,采用“課程采樣強化學習策略(RLCS)”,系統性提升模型跨模態因果推理能力與穩定性。

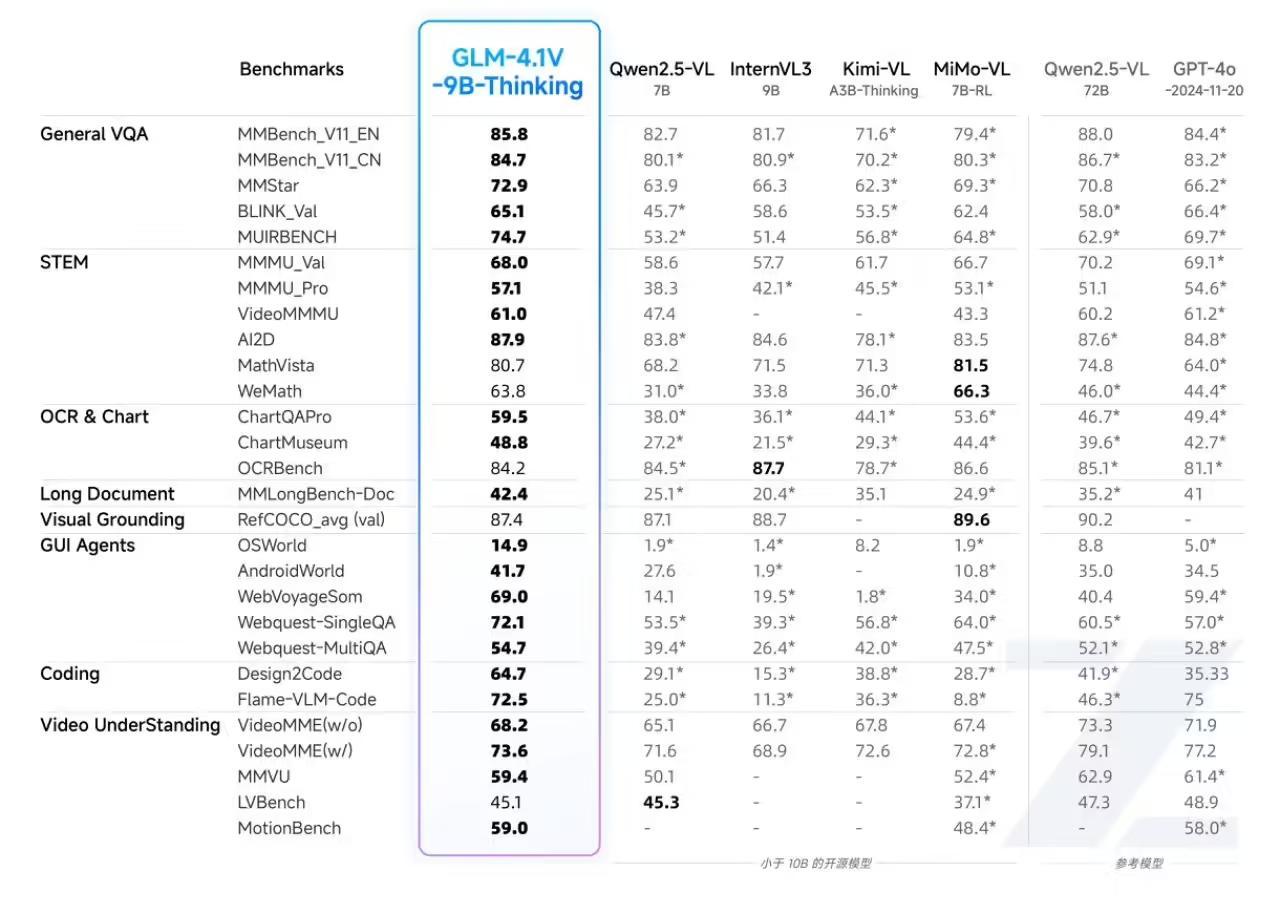

其輕量版GLM-4.1V-9B-Thinking模型參數控制在10B級別,在兼顧部署效率的同時實現性能突破。該模型在MMStar、MMMU-Pro、ChartQAPro、OSWorld等28項權威評測中,有23項達成10B級模型的最佳成績,其中18項更是持平或超越參數量高達72B的Qwen-2.5-VL,充分展現了小體積模型的極限性能潛力。

據官方介紹,該模型特別在以下任務中表現卓越,展示出高度的通用性與穩健性:

圖文理解(Image General):精準識別并綜合分析圖像與文本信息;

數學與科學推理(Math&Science):支持持復雜題解、多步演繹與公式理解;

視頻理解(Video):具備時序分析與事件邏輯建模能力;

GUI與網頁智能體任務(UI2Code、Agent):理解界面結構,輔助自動化操作;

視覺錨定與實體定位(Grounding):語言與圖像區域精準對齊,提升人機交互可控性。

目前,GLM-4.1V-9B-Thinking已在Hugging Face與魔搭社區同步開源。包含兩個模型,分別是GLM-4.1V-9B-Base基座模型,希望能夠幫助更多研究者探索視覺語言模型的能力邊界作;GLM-4.1V-9B-Thinking,具備深度思考和推理能力的模型,正常使用和體驗,均為這一模型。