在華為開發者大會2025的熱烈氛圍中,一場聚焦于“CloudMatrix384昇騰AI云服務:算力聚變,引領行業AI創新”的高峰論壇成功召開。此次論壇匯聚了四位AI領域的領航者,與大約200名開發者進行了深入交流,從核心技術到實際應用場景,全面剖析了新一代昇騰AI云服務如何利用CloudMatrix384超節點突破AI算力、運力、存力的瓶頸,成為推動行業智能化轉型的關鍵力量。

隨著AI大模型的迅猛進化,模型參數規模不斷攀升至千億、萬億級別,傳統算力架構面臨的“算力墻”、“通信墻”、“存儲墻”問題愈發凸顯,成為制約行業創新的關鍵因素。華為云公有云解決方案部CTO劉赫偉在論壇發言中指出,大模型的快速發展實際上是對算力、運力、存力的全面挑戰,而基于CloudMatrix384超節點的昇騰AI云服務,正是突破這些瓶頸、重塑AI基礎設施標準的新方案。

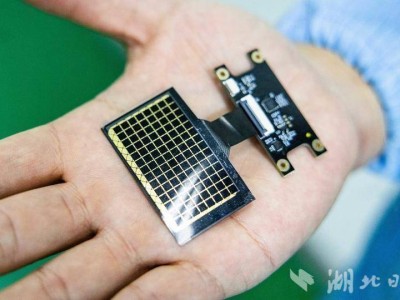

CloudMatrix384昇騰AI云服務通過硬件重構與軟件智能的深度融合,打造了一套高密度、高速度、高效率的AI-Native基礎設施。具體而言,它創新性地將384顆昇騰NPU與192顆鯤鵬CPU通過MatrixLink高速網絡實現全對等互聯,構建出單節點“超級AI服務器”,并支持432個超節點級聯,形成擁有最高16萬張AI加速卡的超大集群,徹底打破了傳統架構的規模限制,為大模型訓練提供了近乎無限的算力資源。

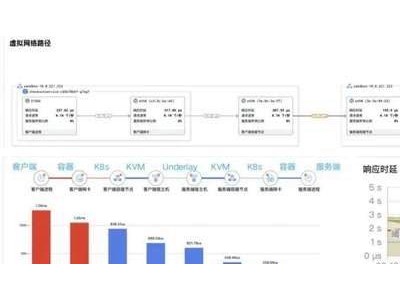

在通信方面,CloudMatrix384實現了納秒級的通信速度,讓算力實現了“無損協同”。其核心網絡架構MatrixLink通過親和性調度、協議重構等技術革新,實現了卡間帶寬高達2.8Tb/s、節點內通信時延降至納秒級、節點間網絡時延僅微秒級的三大性能飛躍。配合PB級虛擬顯存、跨節點/集群DRAM池等創新設計,KV Cache傳輸帶寬提升了10倍,輸出每個Token的時延降至50ms,平均單卡吞吐量躍升至2300 Tokens/s。

在效率方面,CloudMatrix384昇騰AI云服務基于強大的底層算力、網絡、存力,結合上層專家任務智能調度能力,實現了“一卡一專家、一卡一算子任務”的靈活分配與并行推理,將算力有效使用率(MFU)提升了50%以上。同時,結合昇騰云腦,實現了全棧故障感知、診斷與快速自動恢復,徹底解決了傳統集群在訓練和推理過程中的難題。

華為半導體業務部戰略與業務發展總監夏硯秋表示,CloudMatrix384昇騰AI云服務將算力、網絡、存儲等硬件優勢與P/D分離、專家調度、算子優化等軟件實力深度結合,使得千億參數MOE模型的訓練和推理性能邁上了新的臺階。以DeepSeek V3/R1為例,在保持較低時延的同時,實現了2000 TPS以上的吞吐量,綜合性能全面領先。

在行業實踐方面,CloudMatrix384昇騰AI云服務的技術優勢已在多個領域得到驗證。硅基流動作為國內領先的大模型MaaS服務商,早在5月就在CloudMatrix384昇騰AI云服務上部署了DeepSeek-R1,基于大規模專家并行方案和極致通信優化,實現了更高的吞吐量。華為終端智能的核心入口小藝,也借助CloudMatrix384超節點的超大算力、帶寬和專家并行部署規模,實現了極致的推理吞吐與時延,全面提升了交互體驗。

新浪、中科院、面壁智能、科大訊飛等企業和機構也基于CloudMatrix384昇騰AI云服務取得了顯著成果。新浪的“智慧小浪”推理交付效率提升了50%以上,上線速度大幅加快;中科院自研了模型訓練框架,快速構建了AI4S科研大模型;面壁智能實現了小鋼炮模型推理業務性能的大幅提升;科大訊飛則借助CloudMatrix384昇騰AI云服務,實現了訊飛星火大模型的極致推理性能。360打造的“超級搜索”納米A搜索也已開始測試CloudMatrix384超節點。

CloudMatrix384昇騰AI云服務正在電商、社交、文娛、金融、汽車等多個行業的典型智能化場景中深度融入,降低AI創新門檻,擴大AI創新成效,讓更多企業與開發者享受到技術的紅利,共同推動全行業的智能化轉型。此次高峰論壇不僅是一次技術成果的展示,更搭建了一個“技術-場景-生態”的深度交流平臺,標志著AI基礎設施正式邁入“超節點時代”。華為云正以開放的姿態,攜手客戶和合作伙伴,共同書寫行業智能化的新篇章。