在人工智能的浩瀚星空中,九章云極DataCanvas公司再次閃耀出璀璨光芒。近日,該公司在人工智能領域的兩大原創研究成果成功被國際頂級學術會議ICLR(國際學習表征大會)收錄,這一成就不僅彰顯了DataCanvas在AI底層技術創新上的深厚底蘊,也進一步提升了其在國際學術界的影響力。

此次被ICLR 2025正式接納的兩篇論文分別是《A Solvable Attention for Neural Scaling Laws》與《DyCAST: Learning Dynamic Causal Structure from Time Series》。前者聚焦于神經網絡的基礎理解,特別是Transformer架構中的Self-Attention機制的標度定律,從計算角度揭示了其存在的必然性和影響因素;后者則致力于動態因果系統建模,利用NeuralODE技術,在時間序列數據中探索因果結構的動態變化。

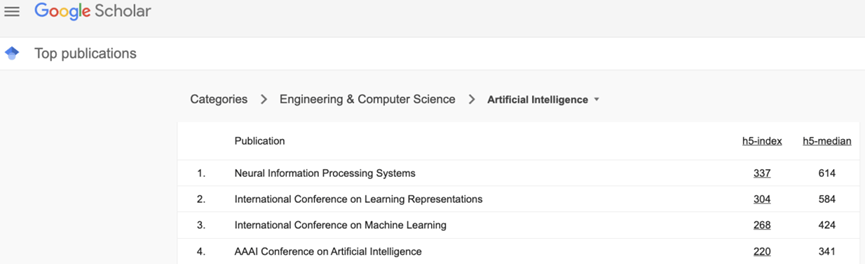

ICLR,作為與NeurIPS、ICML齊名的全球三大人工智能頂級學術會議之一,自2013年由深度學習領域的先驅 Yoshua Bengio、Yann LeCun等人創立以來,便以其對深度學習核心問題的深入探索、嚴格的學術審查標準以及開放協作的社區文化而著稱。在谷歌學術的人工智能出版物中,ICLR擁有第二高的h5-index,成為AI學者發布里程碑式成果的首選舞臺。2025年,ICLR共收到全球投稿11565篇,最終錄用率為32.08%,競爭之激烈可見一斑。

DataCanvas此次雙論文入選,不僅是對其科研實力的有力證明,也是其在AI領域持續深耕、不斷創新的又一里程碑。事實上,這并非DataCanvas首次在國際頂級會議上嶄露頭角。近年來,該公司已在ICLR、NeurlPS、AAAI等多個重要學術會議上發表多篇高質量論文,包括《Implicit Bias of Adversarial Training for Deep Neural Networks》、《Implicit Bias of (Stochastic) Gradient Descent for Rank-1 Linear Neural Network》以及《Effects of Momentum in lmplicit Bias of Gradient Flow folDiagonal Linear Networks》等,這些成果共同構成了DataCanvas在AI領域的堅實學術基礎。

在理論層面,《A Solvable Attention for Neural Scaling Laws》通過解構Transformer的標度定律,為理解大模型的效率困局提供了新的視角。該論文首次展示了在給定條件下,Self-Attention機制與其他模型類似的標度定律,并揭示了這些定律如何受到數據分布等因素的影響。這一發現對于指導大模型的優化和設計具有重要意義。

在系統層面,《DyCAST: Learning Dynamic Causal Structure from Time Series》則開創了時序因果推斷的新篇章。該論文首次處理了同一時刻因果圖內部變量之間的關系以及不同時刻因果圖之間的關系,并基于NeuralODE技術在多個數據集上實現了超越或持平領域內現有方法的性能。這一成果不僅為復雜系統的動態因果建模提供了新的思路,也為AI在醫療、金融等高敏感場景中的應用提供了更可靠的決策支持。

可以預見,隨著九章云極DataCanvas公司在AI領域的持續探索和不斷創新,其“理論可驗證、因果可追溯”的AI技術體系將不斷完善,為全球人工智能的發展注入更加強勁的創新動力。