Transformer的提出者谷歌,剛剛上來給了Transformer梆梆就兩拳(doge)。

兩項關于大模型新架構的研究一口氣在NeurIPS 2025上發布,通過“測試時訓練”機制,能在推理階段將上下文窗口擴展至200萬token。

兩項新成果分別是:

Titans:兼具RNN速度和Transformer性能的全新架構;MIRAS:Titans背后的核心理論框架。核心要解決的,就是Transformer架構在處理超長上下文時的根本局限:計算成本會隨著序列長度的增加而猛增。

不得不說,從Nano Banana到Gemini 3 Pro,再到基礎研究方面的進展,谷歌最近一段時間就是一個窮追猛打的架勢。

也難怪奧特曼要給OpenAI拉“紅色警報”了。

突破Transformer超長上下文瓶頸現在AI領域已經達成共識的是,Transformer雖好,但自注意力機制的效率問題正在日益凸顯:每個token都要“關注”其他所有token,導致計算量和內存消耗與序列長度的平方成正比(O(N2))。

學界已經探索了多種解決方案,比如線性循環網絡(RNNs)和狀態空間模型(SSMs)等。

這類模型通過將上下文壓縮到固定大小來實現快速線性擴展。問題是,這種方法仍然無法充分捕捉超長序列中的豐富信息。

Titans + MIRAS,是谷歌提出的新架構和理論藍圖,目的是將RNN的速度和Transformer的性能結合到一起。

其中Titans可以理解為具體的工具,而MIRAS則是理論框架。兩者共同推進了測試時記憶的概念:

即模型在運行過程中,無需專門的離線重新訓練,就能通過整合更多信息來維持長期記憶。

本質上,可以說這個新架構的重點,是重新定義Transformer的“記憶模式”,將其進化為一種更強大的混合架構。

Titans:在線將上下文擴展至200萬具體來說,Titans引入了一種新的神經長期記憶模塊。

與傳統RNN中固定大小的向量或矩陣記憶不同,該模塊本質上是一個在測試時動態更新權重的多層感知機(MLP)。

其獨特之處就在于,通常模型訓練完后,權重就固定了,但在Titans中,這個記憶模塊在推理階段依然在更新。

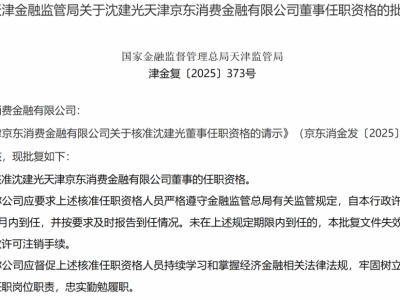

MAC(Memory as Context)是Titans架構的一種主要變體,設計思路是,將長期記憶作為一種額外的上下文信息,直接“喂”給注意力機制。

△MAC架構研究人員發現,這個新的記憶模塊能顯著提升模型的表達能力,使其在不丟失重要上下文的情況下概括并理解大量信息。

更為重要的是,Titans并非被動地存儲數據,而是能在輸入數據中,主動學習如何識別并保留連接各個token的重要關系和概念。其中的關竅是“意外”。

在人類心理學中,我們很容易忘記一些常規的、預期之內的事情,但往往對“意外事件”印象深刻。

對于Titans也存在類似的情況。研究人員將其定義為“驚喜指標”(surprise metric):指模型檢測到當前記憶的內容和新輸入內容之間存在較大差異。

低意外度:比如新詞是“貓”,而模型的記憶狀態已經預測到會有一個動物詞,那么梯度(意外度)就很低。這時模型僅將這個詞作為短期記憶來處理即可。高意外度:如果模型的記憶狀態是正在總結一份嚴肅的財務報告,而新的輸入是香蕉皮的圖片(意外事件),則意外度將非常高。這表明新的輸入很重要或異常,需要優先將其存儲到長期記憶模塊中。這樣對“意外”的判斷使得Titans架構能夠有選擇地更新長期記憶,從而保持快速和高效。

實驗表明,Titans的MAC變體能夠有效將上下文窗口擴展到200萬,并在“大海撈針”任務中保持高準確率。

MIRAS:序列建模的統一框架如果說Titans是跑車,那么MIRAS就是背后的核心引擎。

MIRAS核心目標是讓模型在推理階段也能進行學習。其獨特之處在于,它不把不同的架構視為不同問題的解決方法,而是將其視為解決同一問題的不同途徑:

高效地將新信息與舊信息相結合,同時又不遺漏關鍵概念。

MIRAS將任意序列模型結構為4個關鍵設計選擇:

內存架構:存儲信息的結構(如向量、矩陣,或Titans中的MLP)。注意力偏差:模型優化的內部學習目標,決定模型優先考慮的內容。保留門控(Retention Gate):即“遺忘機制”,用于平衡“學習新知識”與“保留舊記憶”。記憶算法:用于更新記憶狀態的優化算法。現有的序列模型大多依賴均方誤差(MSE)或點積相似度來更新記憶。

MIRAS的另一個創新,是引入非歐幾里得目標函數,允許使用更復雜的數學懲罰機制。

谷歌的研究人員基于MIRAS,創建了三個特定的無注意力模型:

YAAD:使用更溫和Huber Loss來處理錯誤,對異常值(如文檔中的拼寫錯誤)不敏感,魯棒性更強。MONETA:使用Generalized Norms(廣義范數),通過更嚴格的規則來管理注意力和遺忘,提升記憶穩定性。MEMORA:強制記憶像概率圖一樣運作,確保信息整合過程的受控和平衡。實驗結果顯示,基于Titans和MIRAS的模型性能優于最先進的線性循環模型(如Mamba 2),以及規模相近的Transformer基線模型。

更顯著的優勢在于,新架構能夠處理極長上下文,在參數規模小得多的情況下,性能優于GPT-4等大規模模型。

One More Thing超越Transformer的探索還在繼續,但不可否認的是,Transformer依然是大模型時代的理論基石。

那么,曾經一度在競爭中落后的谷歌,是否會后悔公開了Transformer的研究呢?

同樣是在NeurIPS 2025上,Jeff Dean回答了諾獎得主、圖靈獎得主Hinton提出的這個問題:

不,它對世界產生了巨大的積極影響。

這格局,谷谷人人又希希了。