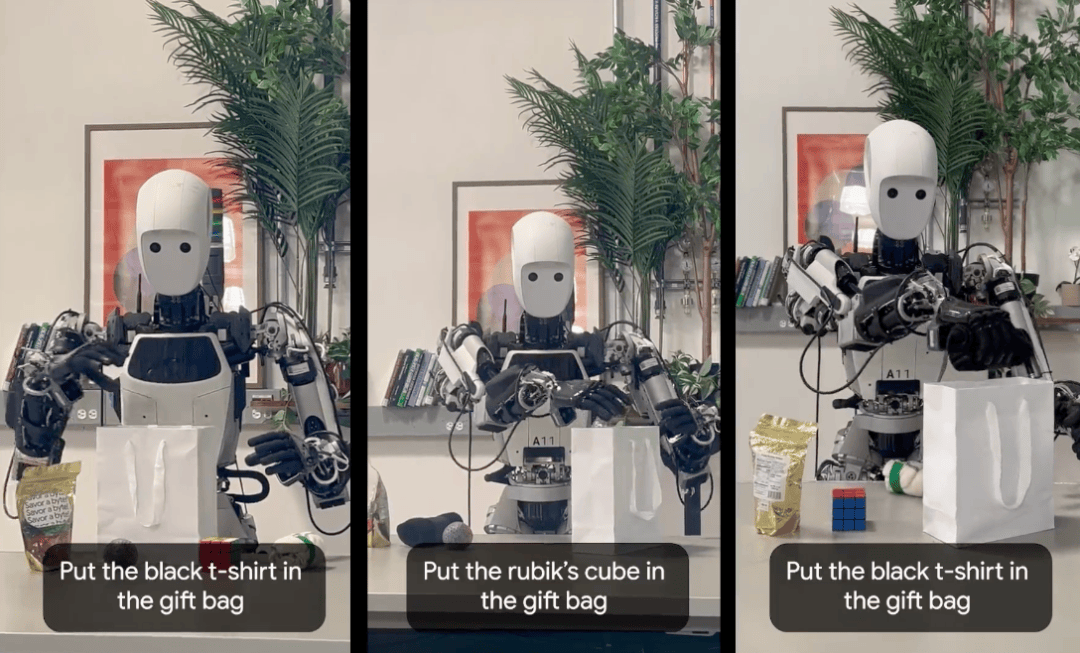

在具身智能領域,VLA(視覺-語言-動作)模型正迅速崛起,成為引領技術革新的關鍵趨勢。近日,谷歌推出了一款名為Gemini Robotics On-Device的VLA模型,該模型專為機器人端側設計,無需依賴數據網絡,即可在設備本地離線運行。

Gemini Robotics On-Device展現了強大的視覺、語義和行為泛化能力。它能夠理解自然語言指令,并執行諸如拉開拉鏈、折疊衣物等高難度任務。這一突破性的進展,標志著機器人在理解和執行復雜指令方面邁出了重要一步。

VLA模型作為具身智能領域的新范式,賦予了機器人將語言意圖、視覺感知與物理動作融為一體的能力。今年以來,不僅谷歌推出了Gemini Robotics系列模型,微軟、Figure AI等海外巨頭也紛紛涉足這一領域。在國內,銀河通用、智元機器人、自變量機器人等公司也在積極布局,推動VLA模型的發展。

谷歌DeepMind團隊推出的Gemini Robotics,被譽為“機器人版的安卓”。這款模型基于Gemini 2.0打造,如同機器人的“大腦”,使其能夠理解復雜環境并執行精細任務。在演示視頻中,Gemini Robotics借助雙臂機器人,流暢地完成了折紙、拉拉鏈等動作,展現了其卓越的性能。

而Gemini Robotics On-Device的發布,更是為機器人產業的落地應用開辟了新路徑。它標志著具身智能從依賴云端算力向本地自主運行的轉變,使得機器人在無網絡環境中也能獨立作業。這一轉變對于機器人在工廠、災區等場景的應用具有重要意義。

Gemini Robotics On-Device具備三大顯著特點:專為靈巧操作設計、可通過微調適應新任務、經過優化可在本地實現超低延遲推理。谷歌還推出了Gemini Robotics SDK,幫助開發者評估模型性能,加速新技能的學習。開發者只需50至100個演示即可完成模型評估,大大降低了機器人學習新技能的門檻。

隨著VLA模型的興起,國內機器人公司也在積極跟進。銀河通用推出了TrackVLA和GroceryVLA兩款端到端VLA大模型。在演示中,搭載了GroceryVLA的機器人Galbot能夠準確理解指令,在商超場景中為顧客選擇食物并送到手中,展現了其強大的零樣本泛化能力。

智元機器人則發布了首個通用具身基座模型智元啟元大模型(GO-1)。該模型采用Vision-Language-Latent-Action架構,實現了利用人類視頻學習和小樣本快速泛化。GO-1已成功部署到智元多款機器人本體之中,提升了其智能化水平。

自變量機器人則研發了WALL-A這一端到端統一具身大模型。該模型突破了傳統分層架構的噪聲傳遞問題,支持從原始傳感器信號到機器人動作的縱向統一和橫向任務統一。自變量機器人在不到一年半的時間內完成了7輪融資,累計融資金額超10億元,其堅持的“大小腦統一的端到端大模型”路線備受投資機構青睞。