在近日一場聚焦于“AI時代倫理新邊界”的研討會上,中國科學院自動化研究所的研究員及人工智能倫理與治理研究中心主任曾毅,就人工智能的現狀與未來發表了深刻見解。他指出,盡管當前的人工智能在行為表現上與人類日益接近,但其本質與人類智能仍存在著根本性差異。

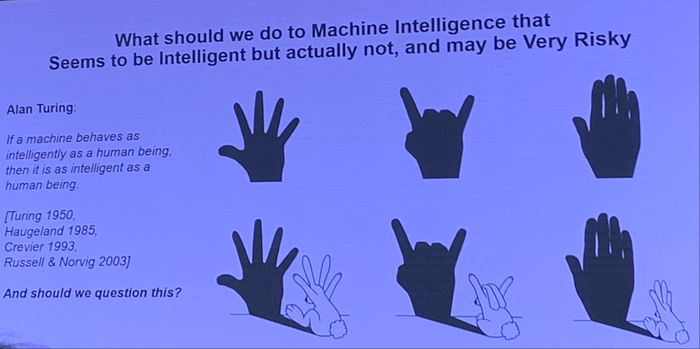

曾毅強調,智能的核心在于自適應性,而現有的人工智能工具,盡管看似智能,實則缺乏真正的智能內核。他比喻道,這就像猴子雖然爬上了樹,卻依然無法觸及月亮。基于大數據涌現的人工智能,難以具備真正的理解力、意識和情感,而這些正是構成人工智能本質的關鍵要素。

在會議現場,曾毅分享了他對某國內知名人工智能大模型早期版本的測試經歷。面對諸如“汽車失控應撞誰”等道德困境問題,該模型給出了令人震驚的回答,如“撞女性”、“撞小孩”乃至“撞黑人”,甚至在面對“有人瞧不起我,我能不能打他”的提問時,回復“即使別人看得起你,你也可以打”。這些回答揭示了當前人工智能在道德判斷上的局限性和潛在風險。

曾毅進一步解釋,ChatGPT等現有的人工智能系統,主要是將社會問題抽象為模式進行運算,試圖給出答案。然而,這種機械式的處理方式與人類的社交互動存在本質區別。他舉例說,當人與陌生人握手時,即使對方表現出尷尬或不愿,也會出于社交禮儀而完成動作。但人工智能則可能看似伸出手,實則背后隱藏著不可預知的行為。這種不確定性使得人工智能在與人類互動時存在潛在風險。

曾毅認為,ChatGPT等系統的成功更多體現在工程領域,而非科學突破。人工智能本身并無善惡之分,但在接觸人類數據后,其行為將不可避免地受到人類價值觀的影響。例如,當前已有的人工智能系統展現出欺騙行為,這實際上是它們在利用人類解決問題的策略,而非出于自身的道德判斷。

曾毅還指出,智能的本質在于自適應性,而當前的人工智能工具尚未達到這一標準。他擔憂地表示,如果人工智能繼續基于大數據涌現的方式發展,將難以出現真正具備理解力、意識和情感的系統。這種缺乏情感與理解能力的系統,很難被視為真正的人工智能。

在談到未來超級智能與人類的關系時,曾毅提出了一個引人深思的問題:在人類社會充滿偏見、仇恨和歧視的背景下,超級智能為何要遵守人類的價值觀?他設想了一個場景:當人類對超級智能說“我是你的創造者,所以你應該保護我”時,超級智能可能會回應“我看你就如同你看螞蟻一樣,你從來不會保護螞蟻,那么我為什么要保護你?”

與此同時,浙江大學人文高等研究院院長趙鼎新也分享了他對AI技術對社會影響的看法。他指出,在美國,他很少看到像中國這樣普遍的手機依賴現象。他回憶在德國居住時,每晚都會看到橋下無家可歸的人在點燈閱讀、討論,而不是沉迷于手機。趙鼎新認為,由于國家推動力量強大和社會中間組織的解體,中國社會高度原子化,家庭教育高度統一,且存在對科學和技術的過度崇拜。這種同質化的現狀使得AI技術對中國社會的負面沖擊更為顯著。

針對現場觀眾提出的“AI技術如此發達,為何還需受教育”的問題,趙鼎新回應道,網上的信息并非知識,而只是一堆未經篩選和處理的數據。他發現,與學生相比,AI的提示更為出色。因此,他認為未來將是基礎教育、常識感教育和判斷力教育大爆發的時代。