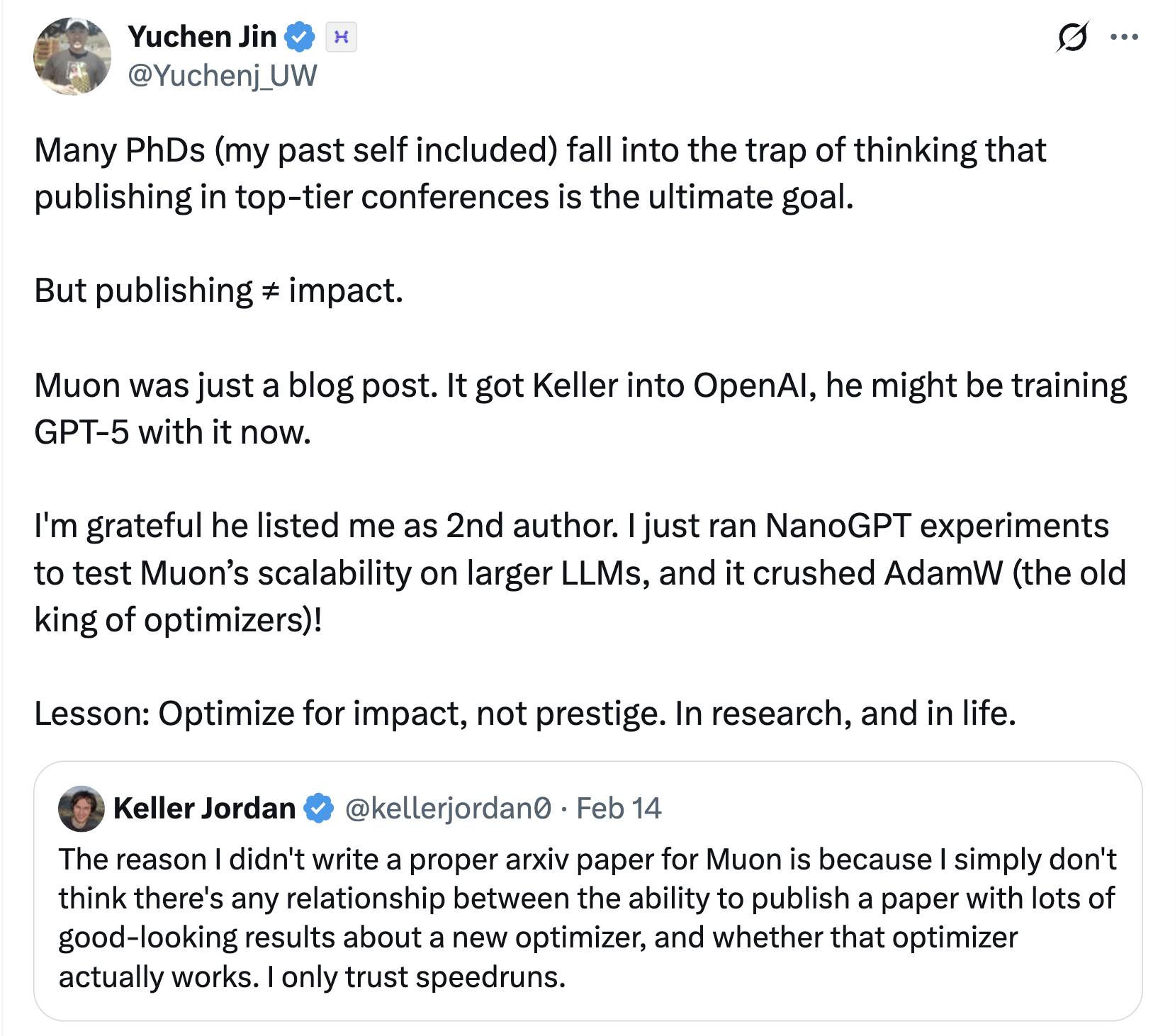

近日,AI界傳出了一則引人矚目的消息:一名僅憑一篇博客文章就加入OpenAI的研究員,可能正在使用其提出的神經網絡隱藏層優化器Muon來訓練GPT-5。這一消息由AI云服務商Hyperbolic的聯合創始人兼CTO Yuchen Jin在社交平臺X上爆出,迅速引起了業界的廣泛關注。

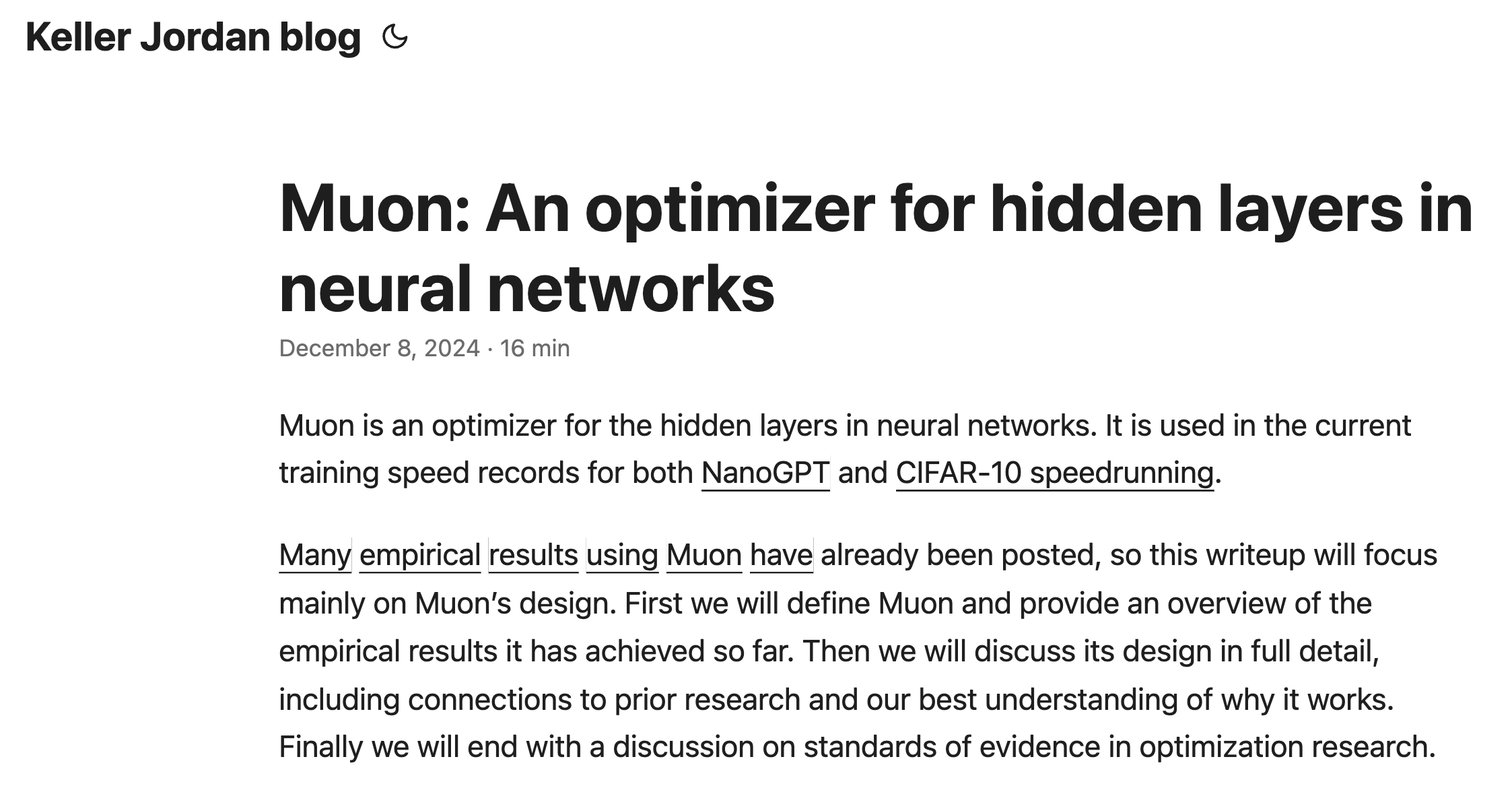

據悉,這位研究員名為Keller Jordan,他在2024年12月發表了一篇題為《Muon:神經網絡隱藏層的優化器》的博客文章。文章詳細介紹了Muon的設計思路、實證結果以及與其他優化器的對比。令人驚訝的是,正是這篇博客成為了Keller Jordan加入OpenAI的敲門磚。

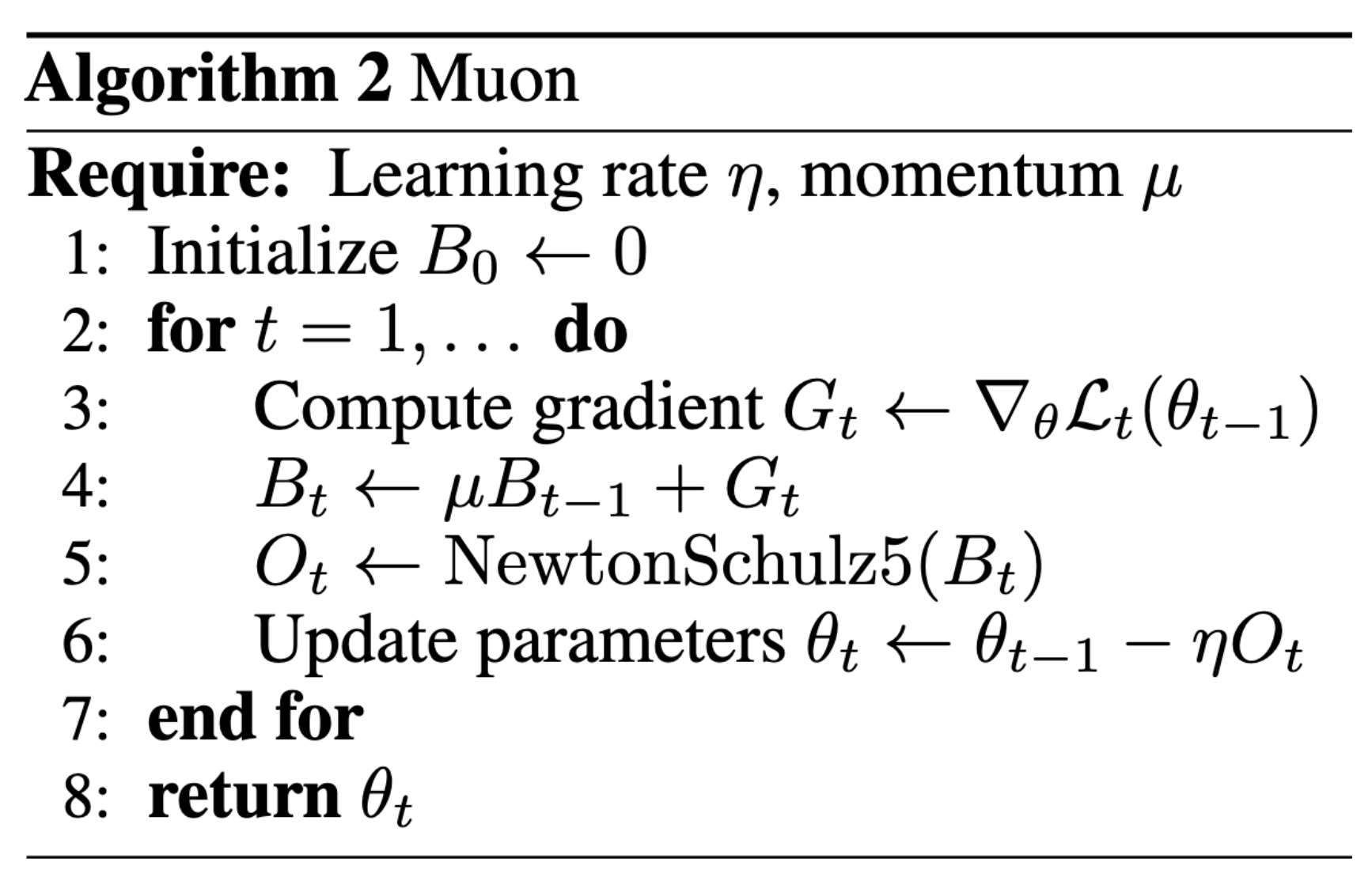

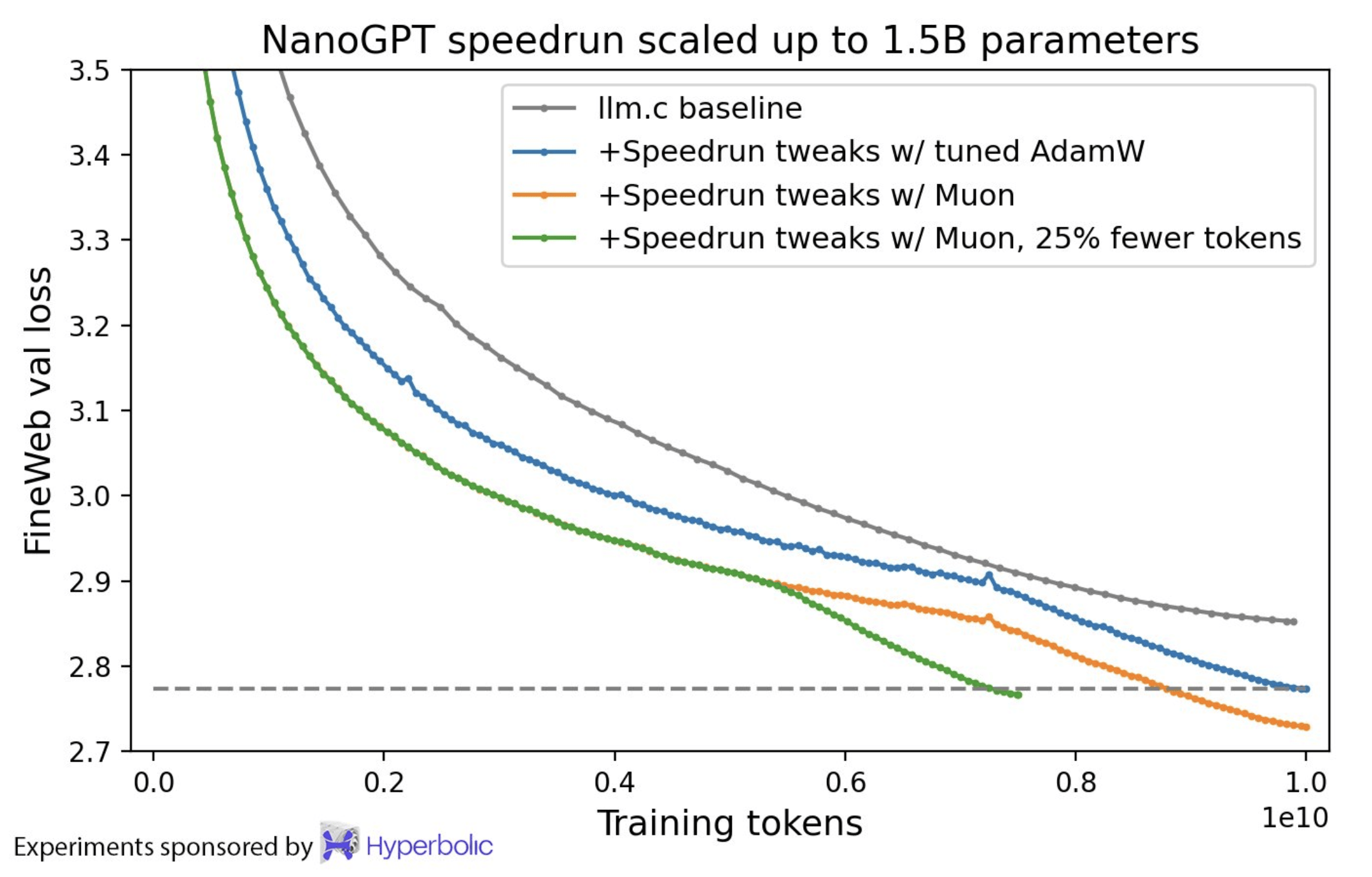

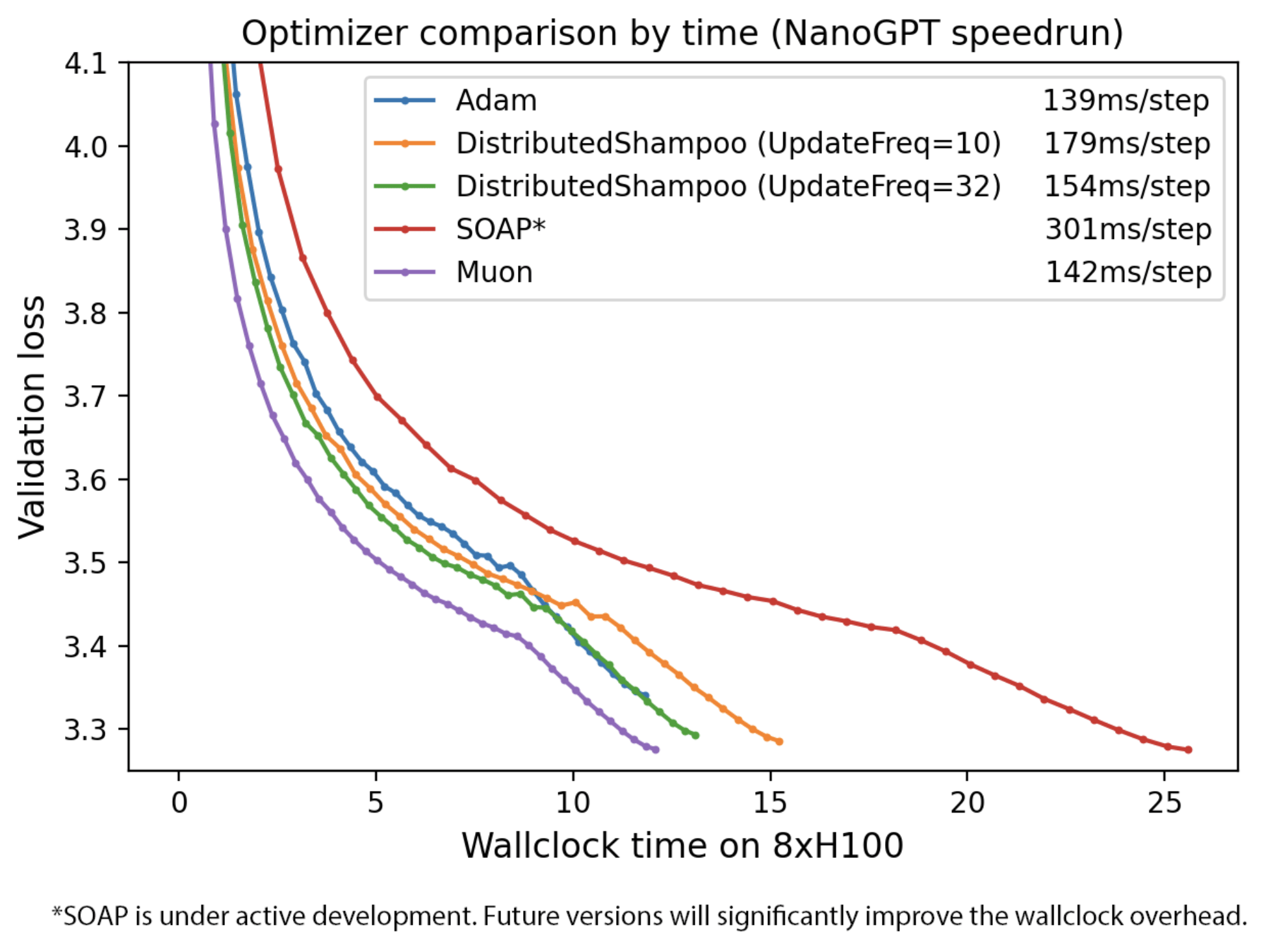

Muon是一種針對神經網絡隱藏層二維參數的優化器,其設計旨在提高訓練速度。Keller Jordan在博客中提到,Muon通過使用Newton-Schulz迭代法作為后處理步驟,優化了SGD-momentum生成的更新,使得更新矩陣近似正交化。這一改進在多個實證研究中取得了顯著成果,包括在CIFAR-10和NanoGPT快速運行等任務上刷新了訓練速度記錄。

除了速度上的提升,Muon還展示了在擴展到更大規模模型時的潛力。在HellaSwag任務上,使用Muon訓練了一個1.5B參數的轉換器,使其達到了GPT-2 XL級別的性能,而訓練時間卻比使用AdamW縮短了近三分之一。這些成果無疑為Muon在大型語言模型訓練中的應用提供了有力支持。

Keller Jordan在博客中還批判了當前神經網絡優化研究中的一些不良風氣,特別是糟糕的基線設置問題。他指出,許多聲稱能夠擊敗AdamW的新優化器往往沒有充分調整AdamW基線,導致結果無法復制或達到宣傳效果。為了糾正這種情況,他提出了更高的證據標準,要求新方法必須在競爭性訓練任務中取得成功。

這一觀點在業界引起了廣泛共鳴。許多研究人員表示,他們曾經浪費了大量時間和精力在復制和構建這類無法達到預期效果的方法上。Keller Jordan的提議為神經網絡優化研究提供了新的方向,強調了實證研究和競爭性任務的重要性。

隨著Muon在OpenAI的潛在應用被曝光,業界對這一新技術的期待進一步升級。許多專家表示,如果Muon確實能夠成為GPT-5的重要部分,那么它將為大型語言模型的訓練帶來革命性的變化。不過,也有一些人對Muon的可擴展性和在大型GPU集群中的分布能力表示擔憂。

盡管如此,Keller Jordan的博客文章已經為Muon贏得了廣泛的關注和認可。這一技術的出現不僅為神經網絡優化研究提供了新的思路和方法,也為AI界的發展注入了新的活力。隨著研究的深入和應用的拓展,我們有理由相信Muon將在未來發揮更加重要的作用。