在人工智能領域的探索之旅中,meta AI研究團隊近期宣布了一項重大進展,正式揭曉了V-JEPA2——一個專為視頻理解設計的聯合嵌入預測架構2.0版本。該項目由meta的首席AI科學家Yann LeCun親自掛帥,憑借自我監督學習技術和零樣本機器人控制能力,為視頻解析與物理環境模擬開辟了前所未有的路徑。

V-JEPA2,作為一個非生成式的視頻理解模型,它超越了傳統框架,能夠觀察并分析視頻內容,不僅識別當前事件,更能預測未來走向。其工作原理類似于人類的認知模式,通過自我監督學習,從龐大的未標注視頻資料庫中提煉出深層次的抽象特征,從而構建了對物理世界的內在認知模型。這一“世界模型”的架構,讓V-JEPA2能夠洞悉視頻中物體的互動邏輯,預測它們的運動軌跡及場景演變。

meta透露,V-JEPA2的訓練素材覆蓋了超過百萬小時的視頻,涵蓋了豐富的場景和交互情境。如此大規模的數據輸入,賦予了模型強大的泛化性能,使其能夠輕松應對新任務與未知環境,無需額外訓練。

V-JEPA2的技術革新主要體現在五大核心層面:首先,其自我監督學習機制大幅降低了對標注數據的依賴,有效節省了數據準備的成本;其次,通過遮擋預測機制,模型學會了“填空”,即預測被遮擋部分的內容,深化了對視頻語義的理解;再者,V-JEPA2專注于抽象表征的學習,而非簡單的像素級重建,能夠把握物體間的關系和動態,理解視頻的深層次含義;其世界模型架構使模型能夠“預演”物體的運動和交互,如預測球的彈跳路徑或物體的碰撞效應;最后,V-JEPA2的高效遷移能力,特別是在零樣本學習方面的卓越表現,使其在機器人控制領域尤為亮眼。

在實際應用中,V-JEPA2的零樣本機器人控制能力尤為引人注目。傳統機器人控制模型往往需要針對特定任務進行大量訓練,而V-JEPA2憑借其強大的遷移能力和對物理世界的深刻理解,能夠在未經專門訓練的情況下,指導機器人完成新任務。這意味著,機器人只需觀察視頻,就能實時理解環境并執行操作,如搬運物體或在陌生環境中導航。

meta強調,V-JEPA2的“世界模型”能力為機器人在現實世界的應用開辟了廣闊前景。例如,機器人通過觀察視頻,能夠學習重力、碰撞等物理法則,進而執行復雜的任務,如烹飪或家務協助。這一特性為智能機器人和增強現實(AR)設備的未來發展奠定了堅實基礎。

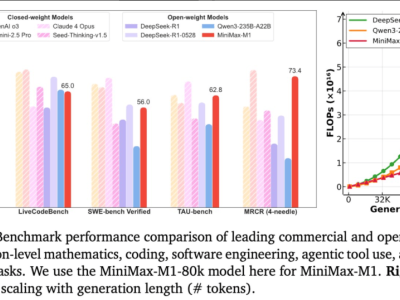

在性能表現上,V-JEPA2同樣不負眾望。根據meta提供的數據,該模型在多項基準測試中均表現出色,特別是在動作理解和視頻任務上,超越了基于ViT-L/16和Hiera-L編碼器的傳統模型。與NVIDIA的Cosmos模型相比,V-JEPA2的訓練速度快了30倍,展現了極高的效率。在低樣本場景下,V-JEPA2同樣表現優異,僅需少量標注數據即可達到高精度,證明了其強大的泛化能力。

meta秉持開放科學的理念,將V-JEPA2以CC-BY-NC許可證發布,供全球研究人員和開發者免費使用。模型代碼已在GitHub上公開,并支持在Google Colab和Kaggle等平臺上運行。meta還推出了三項物理推理基準測試,為視頻理解和機器人控制領域的研究提供了標準化的評估工具。