蘋果公司的科研團隊最近公布了一項關于大型語言模型(LLMs)的深入研究,對傳統認知中的LLMs能力提出了深刻質疑。這項研究揭示,即便LLMs融入了復雜的自我反思機制,它們在高復雜度問題面前仍顯得力不從心,無法展現出普遍的推理能力。

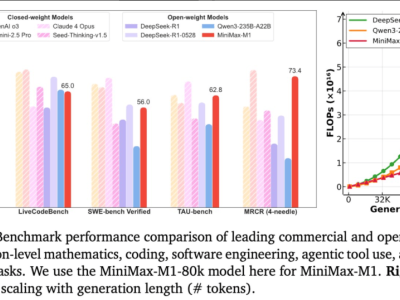

研究發現,LLMs在處理問題時的表現存在一個明顯的分界點。面對低復雜度的問題,LLMs的表現優于邏輯推理模型(LRMs)。然而,當問題復雜度上升到中等水平時,LRMs開始占據優勢。而在高復雜度的問題面前,兩者都顯得無能為力。這一發現表明,LLMs在處理復雜邏輯時的局限性不容忽視。

不僅如此,LLMs在執行精確計算時也顯得捉襟見肘。甚至在處理一些簡單問題時,LLMs也會出現“過度思考”的現象,導致效率低下。這一發現進一步加劇了人們對LLMs能力的擔憂。

紐約大學的Gary Marcus教授對此表示,LLMs并不能完全替代那些經過精心設計的傳統算法。他認為,通往通用人工智能(AGI)的道路遠比想象中更為艱難。蘋果的這項研究無疑為這一觀點提供了有力的支持。

研究還指出,LLMs在解決結構性問題時的表現同樣不盡如人意。例如,在解決漢諾塔問題時,LLMs的表現令人失望。即便直接給出標準算法,LLMs也難以正確執行。這一發現再次證明了LLMs在特定問題上的不可靠性。

盡管LLMs在某些領域確實展現出了其獨特的優勢,但這項研究提醒我們,它們并非解決所有問題的萬能鑰匙。在未來的研究和應用中,我們需要更加理性地看待LLMs的能力,避免過度依賴和夸大其效果。