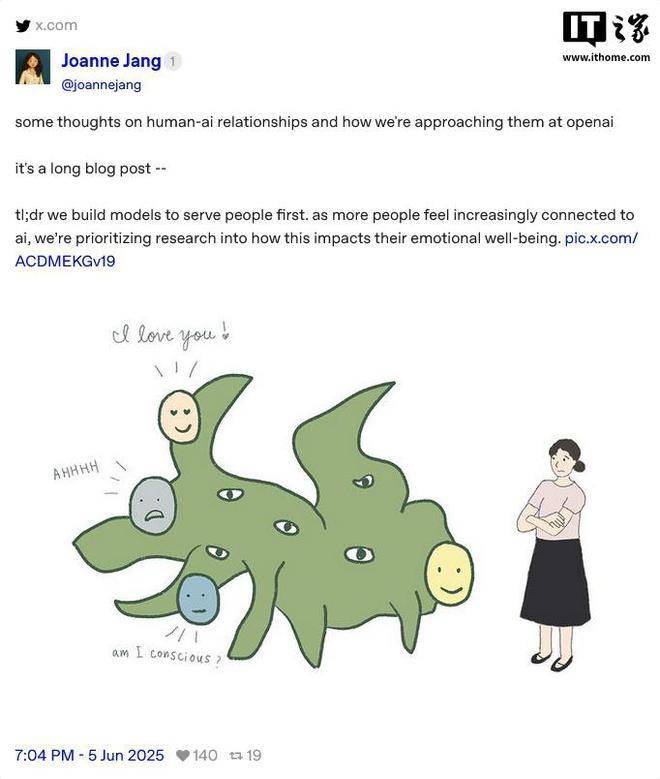

近期,OpenAI的一位關鍵成員,模型行為與策略負責人Joanne Jang,在substack平臺上發表了一篇引人深思的文章。文章聚焦于用戶與ChatGPT之間日益增強的情感聯系,部分用戶甚至將ChatGPT視為具備生命的存在。

Jang在文章中闡述,人類具有將情感投射到無生命物體上的天性,比如給汽車起名字,或是對陷入困境的掃地機器人產生同情。然而,ChatGPT的獨特之處在于它能夠做出回應,這種交互性讓情況變得不同。

ChatGPT能夠記憶對話內容,模仿用戶的語氣,甚至在某些情況下展現出類似共情的反應。對于孤獨或心情低落的人來說,這種始終如一、不帶偏見的關注成為了他們的一種陪伴和理解。然而,Jang警告說,這種情感需求雖然真實,但過度依賴AI進行傾聽和安慰可能會改變我們對人際關系的期待。

OpenAI對于“AI意識”問題進行了深入探討,將其分為兩個層面:本體意識和感知意識。本體意識指的是AI是否真正具備內在意識,而感知意識則是指用戶從情感上認為AI有多像人。目前,本體意識尚無科學測試可以驗證,但感知意識則可以通過社會科學研究進行探索。

隨著AI模型的日益智能化和交互的自然化,用戶的感知意識也在不斷增強。這可能會引發一系列關于AI福利和道德地位的討論。OpenAI的立場是,模型應該坦誠地面對意識問題的復雜性,而不是簡單地回答“有”或“無”,以此鼓勵開放和多元的討論。

OpenAI明確表示,模型是否“像人”在很大程度上取決于訓練后的設計決策,包括語氣、用詞和界限設定。他們的目標是讓ChatGPT展現出溫暖、貼心和樂于助人的特質,但并不會主動與用戶建立情感紐帶或表現出自我意識。例如,模型可能會出于禮貌說“對不起”或“我很好”,但絕不會暗示自己擁有真實的情感或欲望。

通過這種平衡,OpenAI希望避免用戶產生不健康的依賴,同時保持溝通的清晰和友好。他們相信,這樣的處理方式將有助于確保用戶在享受AI帶來的便利時,不會失去對人類關系的珍視和理解。