近期,關于OpenAI的o3人工智能模型在基準測試上的表現引發了廣泛討論和質疑。這一爭議的核心在于,OpenAI首次發布o3模型時宣布的高分成績與第三方基準測試結果之間存在較大差異。

去年12月,OpenAI自豪地宣布,其o3模型在極具挑戰性的數學問題集FrontierMath上取得了突破性的成績,正確回答了超過四分之一的問題。這一成績遠超競爭對手,排名第二的模型僅能正確回答約2%的問題。OpenAI首席研究官Mark Chen在直播中強調,o3模型在內部測試中,通過激進的計算設置,達到了超過25%的正確率,遠超市場上所有其他產品。

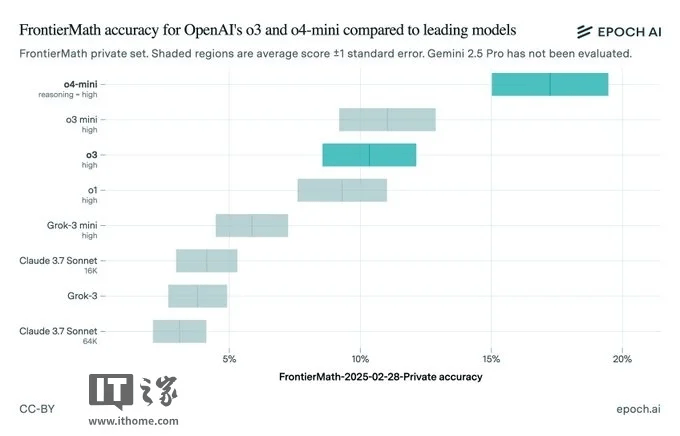

然而,事情似乎并沒有那么簡單。上周五,負責FrontierMath的Epoch研究所公布了其對o3模型的獨立基準測試結果,發現o3的得分僅為約10%,遠低于OpenAI此前聲稱的最高分數。這一結果立即引發了外界對OpenAI透明度和模型測試實踐的質疑。

值得注意的是,OpenAI在12月份公布的基準測試結果中,其實已經包含了一個與Epoch測試結果相符的較低分數。Epoch在報告中指出,測試設置的差異以及評估使用的FrontierMath版本更新可能是導致結果差異的原因。Epoch還提到,OpenAI在內部評估時可能使用了更強大的計算框架和更多的測試時計算資源。

與此同時,ARC Prize基金會也在X平臺上發布消息,證實了Epoch的報告。ARC Prize指出,公開發布的o3模型是一個針對聊天/產品使用進行了調整的不同模型,且所有發布的o3計算層級都比他們測試的版本要小。這一信息進一步加劇了外界對OpenAI基準測試結果的疑慮。

盡管公開版本的o3未能完全達到OpenAI測試時的表現,但OpenAI并未因此停滯不前。該公司后續推出的o3-mini-high和o4-mini模型在FrontierMath上的表現已經優于o3,且計劃在未來幾周內推出更強大的o3版本——o3-pro。

然而,這一系列事件再次提醒人們,在看待人工智能基準測試結果時需要保持謹慎。尤其是當結果來自一家有產品需要銷售的公司時,更需要審慎對待。隨著人工智能行業競爭的加劇,各供應商紛紛急于通過推出新模型來吸引眼球和市場份額,這也導致基準測試“爭議”變得越來越常見。

事實上,這并非OpenAI首次陷入此類爭議。今年1月,Epoch因在OpenAI宣布o3之后才披露其從OpenAI獲得的資金支持而受到批評。許多為FrontierMath做出貢獻的學者直到公開時才知道OpenAI的參與。近期還有其他人工智能公司如xAI和meta也因基準測試問題而受到質疑。

這一系列事件不僅揭示了人工智能基準測試中的復雜性和不確定性,也促使人們更加關注模型的透明度和測試實踐的合理性。對于消費者和行業觀察者而言,保持審慎和理性的態度至關重要。