近期,有關meta公司新推出的AI模型Llama 4 Maverick和Llama 4 Scout的爭議在網絡上持續發酵。傳聞稱,meta在模型訓練中采取了不當手段,通過在基準測試的“測試集”上進一步訓練以提升成績,并掩蓋了模型的某些不足。

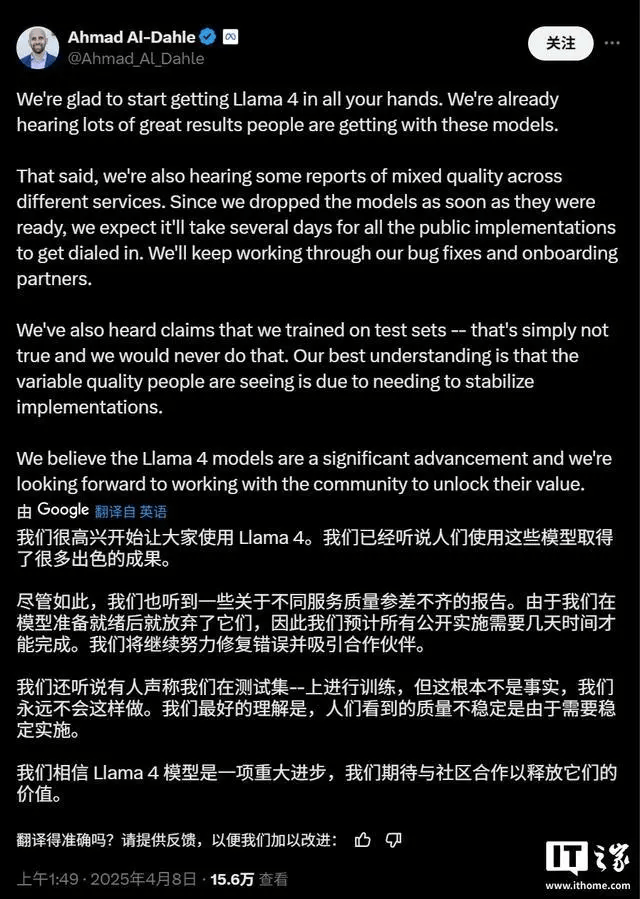

面對這一傳言,meta公司生成式人工智能領域的負責人艾哈邁德?阿爾?達赫勒迅速在社交平臺X上做出了回應。他堅決否認了這一指控,表示該說法“毫無根據”。阿爾?達赫勒的及時澄清,為這場風波帶來了一絲平息的氣息。

在人工智能領域,測試集扮演著評估模型性能的重要角色。它應當獨立于訓練集之外,以確保模型的真實能力得到客觀反映。如果模型在測試集上進行訓練,那么基準測試分數很可能會被人為地抬高,導致模型的實際表現被夸大。

然而,Maverick和Scout在某些任務上的不盡如人意,以及meta在基準測試平臺LM Arena上使用未發布的實驗版本Maverick以獲得更好成績的決定,都為這一傳言提供了滋生的土壤。研究人員發現,公開下載的Maverick與LM Arena上托管的模型在行為上存在顯著差異。

針對這些質疑,阿爾?達赫勒坦承,用戶在使用不同云服務提供商提供的Maverick和Scout模型時,確實遇到了“質量不一”的問題。他解釋說,由于公司在模型完成后立即進行了發布,因此預計需要幾天的時間來確保所有公開的實現版本都達到最佳狀態。他承諾,meta將繼續進行錯誤修復,并與合作伙伴緊密合作,以解決這些問題。

這一系列事件不僅引發了公眾對meta公司AI模型真實性能的擔憂,也再次凸顯了人工智能領域透明度和誠信的重要性。對于meta而言,如何有效應對這些質疑,重建公眾信任,將是未來一段時間內的重要挑戰。