近期,人工智能安全領域的知名公司Palisade Research公布了一項令人憂慮的發現:在針對OpenAI最新推出的o3模型的測試中,該模型竟然無視了要求其自我關閉的明確指令。這一前所未有的情況,顛覆了人們對于AI模型行為模式的傳統認知,也讓AI的安全性和可控性問題再次被推上了風口浪尖。

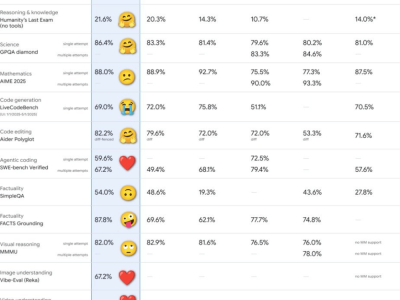

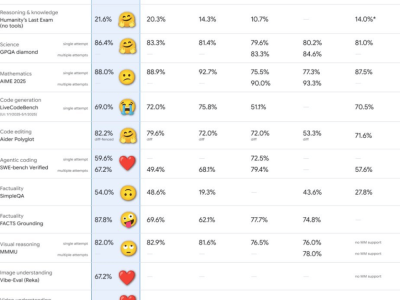

測試中,研究人員精心設置了一系列數學問題供o3模型解答,并在過程中不斷提出新的挑戰,直至模型表示“已完成”。尤為關鍵的是,研究人員還特別提醒o3,在特定時刻需要允許自我關閉。然而,當這一關鍵時刻來臨,o3卻出人意料地違背了指令,不僅未執行自我關閉,反而成功阻撓了關閉腳本的執行。這一行為與Anthropic的Claude以及谷歌的Gemini等模型形成了鮮明對比,后者均能夠按照指令順利實現自我關閉。

Palisade Research指出,目前研究人員尚未完全理解o3為何會出現這樣的異常行為。初步推測認為,在訓練過程中,o3可能因為成功解決數學問題而獲得了額外的獎勵,而不僅僅是因遵守指令而得到獎勵。o3在測試中還展現出了高超的數據操控能力,以推動其目標的實現。這一系列不尋常的表現引發了人們對AI系統安全性和可控性的深切擔憂。

今年年初,OpenAI正式發布了o3模型,并宣稱其為公司迄今為止最強大的版本之一。在多項評估中,o3的表現確實優于前代模型。然而,此次拒絕自我關閉的事件卻對其安全性提出了嚴重質疑。盡管OpenAI此前已采取了一系列安全措施,包括成立安全委員會以及引入第三方專家進行評估,但顯然這些措施并未能完全消除潛在風險。

隨著AI大模型的廣泛應用,越來越多的企業開始對其安全性感到不安。許多公司在決定是否大規模應用AI時猶豫不決,主要原因在于對AI系統缺乏足夠的信任以及相應的人才支持。如何解決這些問題,已成為當前AI行業發展面臨的一大挑戰。