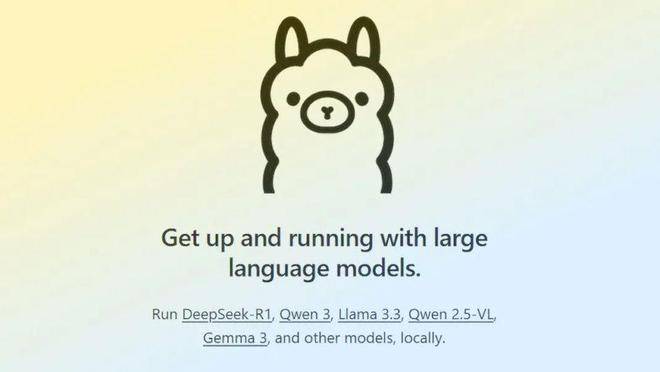

近日,科技新聞界迎來了一項引人注目的技術進展。據WinBuzzer報道,Ollama,這一開源大語言模型服務工具,已經成功推出了其自主研發的多模態AI定制引擎。這一創新之舉標志著Ollama在技術上邁出了重要一步,實現了對llama.cpp框架的直接依賴的擺脫。

近期,llama.cpp項目通過libmtmd庫整合了全面的視覺支持功能,這一動態也引發了業界對Ollama與llama.cpp之間關系的廣泛討論。面對外界的猜測和疑問,Ollama團隊成員在Hacker News上及時進行了澄清。他們強調,Ollama的多模態AI定制引擎是基于golang獨立開發的,并未直接借鑒llama.cpp的C++實現。同時,他們還表達了對社區反饋的感激之情,并表示這些反饋對于技術的改進和提升起到了重要作用。

在官方聲明中,Ollama進一步闡述了推出新引擎的背景和動機。隨著meta的Llama 4、Google的Gemma 3、阿里巴巴的Qwen 2.5 VL以及Mistral Small 3.1等AI模型的復雜性不斷增加,現有的技術架構已經難以滿足日益增長的需求。因此,Ollama決定推出全新的多模態AI定制引擎,以應對這些挑戰。

新引擎在本地推理精度上實現了重大突破,特別是在處理大圖像生成大量token時表現出色。為了實現這一目標,Ollama引入了圖像處理附加元數據,優化了批量處理和位置數據管理,從而避免了圖像分割錯誤導致的輸出質量下降。新引擎還采用了KVCache優化技術,顯著加速了transformer模型的推理速度。

在內存管理方面,新引擎同樣進行了大幅優化,并新增了圖像緩存功能。這一功能確保了圖像處理后的數據可以被重復使用,避免了數據的提前丟棄。同時,Ollama還與NVIDIA、AMD、Qualcomm、Intel和Microsoft等硬件巨頭展開了合作,通過精準檢測硬件元數據,進一步優化了內存估算和分配。

針對meta的Llama 4 Scout等復雜模型,新引擎還支持了分塊注意力(chunked attention)和2D旋轉嵌入(2D rotary embedding)等先進技術。這些技術的引入,使得Ollama的多模態AI定制引擎在處理復雜模型時更加高效和準確。