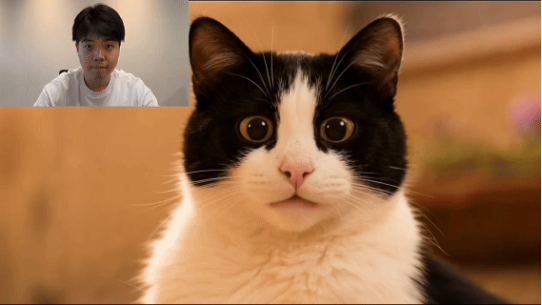

9月19日消息,阿里開源全新動作生成模型通義萬相Wan2.2-Animate,該模型同時支持動畫和替換兩種模式,輸入一張角色圖片和一段參考視頻,可將視頻角色的動作、表情遷移到圖片角色中,賦予圖片角色動態表現力;同時還可在保留原始視頻的動作、表情及環境的基礎上,將視頻中的角色替換為圖片中的角色。該模型支持驅動人物、動漫形象和動物照片,可應用于短視頻創作、舞蹈模板生成、動漫制作等領域。

去年年初,阿里推出了Animate Anyone模型,基于該模型的「全民舞王」功能一度火爆全網,兵馬俑、萌寵跳科目三的視頻在社交平臺刷屏。但此前的技術框架無法同時控制動作、表情和環境交互,生成的視頻依舊存在不自然的問題。

此次,通義萬相團隊構建了一個涵蓋說話、面部表情和身體動作的大規模人物視頻數據集,并基于通義萬相圖生視頻模型進行后訓練。Wan2.2-Animate將角色信息、環境信息和動作等,規范到一種統一的表示格式,實現了單一模型同時兼容兩種推理模式;針對身體運動和臉部表情,分別使用骨骼信號和隱式特征,配合動作重定向模塊,實現動作和表情的精準復刻。在替換模式中,團隊還設計了一個獨立的光照融合LoRA,用于保證完美的光照融合效果。

實測結果顯示,Wan2.2-Animate在視頻生成質量、主體一致性和感知損失等關鍵指標上,超越了StableAnimator、LivePortrait等開源模型,是目前性能最強的動作生成模型,在人類主觀評測中,Wan2.2-Animate甚至超越了以 Runway Act-two代表的閉源模型。

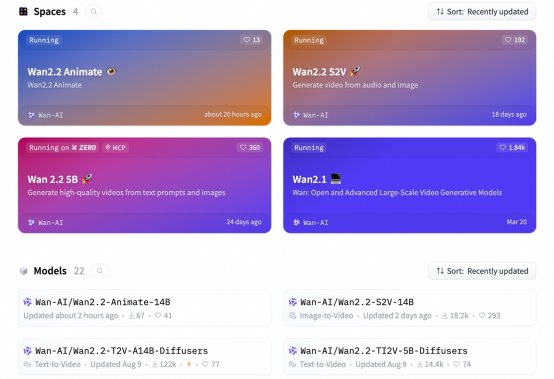

自今年 2 月以來,通義萬相已連續開源20多款模型,在開源社區和三方平臺的下載量已超3000萬,是開源社區最受歡迎的視頻生成模型之一。通義萬相模型家族已支持文生圖、文生視頻、圖生視頻、人聲生視頻和動作生成等10多種視覺創作能力。