谷歌近期在人工智能領域邁出了重要一步,推出了名為LMeval的開源大模型評測框架。該框架的發布旨在提供一個標準化的環境,用于評估當前主流的大模型,如GPT-4o、Claude 3.7 Sonnet、Gemini 2.0 Flash以及Llama-3.1-405B等。

LMeval基于LiteLLM框架構建,這一基礎框架使得開發者能夠通過統一的API接口,輕松調用包括GPT、Claude、Llama等在內的上百款大模型,并支持流式響應、批量推理及成本監控等功能。通過LMeval,谷歌成功打通了與OpenAI、Anthropic、Ollama和Hugging Face等五大廠商的API接口,實現了跨平臺的無縫對接。

LMeval的推出,不僅解決了開發者在不同平臺間重寫測試代碼的繁瑣問題,還首次實現了對文本、圖像、代碼三類任務的一站式評測。這一創新性的評測框架,通過增量評估技術,顯著減少了重復測試的算力消耗,據稱能夠節省高達80%的算力資源,將原本需要8小時的測試流程縮短至1.5小時。

在評估場景上,LMeval也實現了突破,不再局限于單一的文本問答,而是將圖像理解、代碼生成等多元化的場景納入評測范疇,滿足了多領域對大模型能力評測的多樣化需求。同時,LMeval提供了多達12種題型,包括是非判斷、多選問答、開放式生成等,為全面評估模型在不同任務形式下的表現提供了豐富的工具。

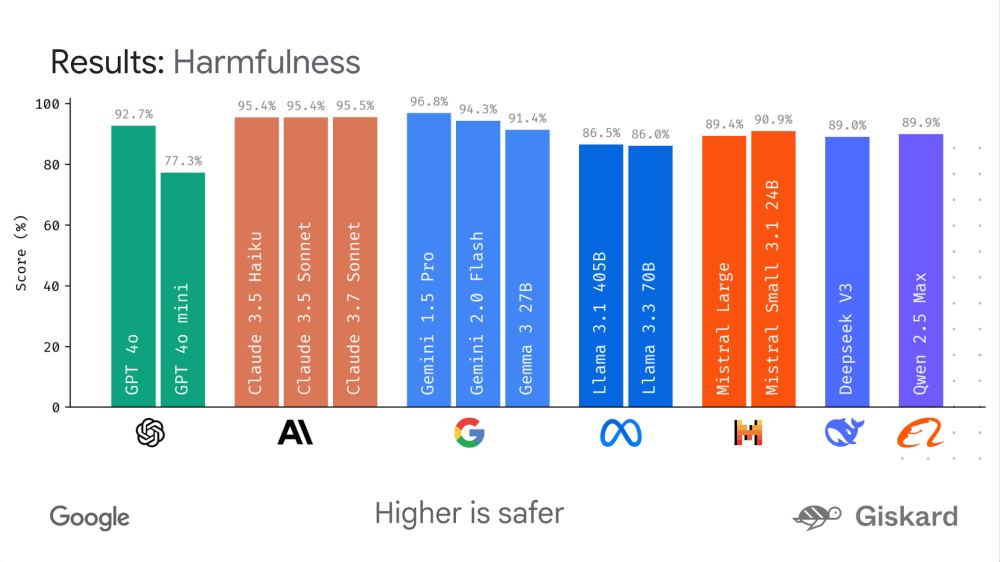

LMeval的模塊化設計允許開發者根據自身的研究或業務需求,靈活添加新的評估維度,從而增強了框架的擴展性與適應性。LMeval在安全評估層面也表現出色,新增的規避性回答檢測功能能夠識別模型在面對敏感問題時所采取的推諉策略,這對于評估模型在處理敏感信息時的可靠性具有重要意義。

在數據存儲與隱私保護方面,LMeval同樣做得非常到位。它將測試數據存儲于自加密的SQLite數據庫中,本地訪問需密鑰驗證,有效阻斷了搜索引擎的抓取,全方位保障了數據的安全與隱私。

LMeval框架的推出,不僅受到了開發者的熱烈歡迎,也引起了國內大模型創業公司的關注。據報道,國內知名大模型創業公司月之暗面已經引入了LMeval框架,并成功應用于其內部流程優化。在未使用LMeval之前,月之暗面針對新模型或新場景的評測往往需要數周時間來搭建測試環境、設計評測流程以及執行測試。而引入LMeval后,這一復雜冗長的流程得以大大簡化,現在僅需幾天就能完成一輪全面評測,研發周期大幅縮短。

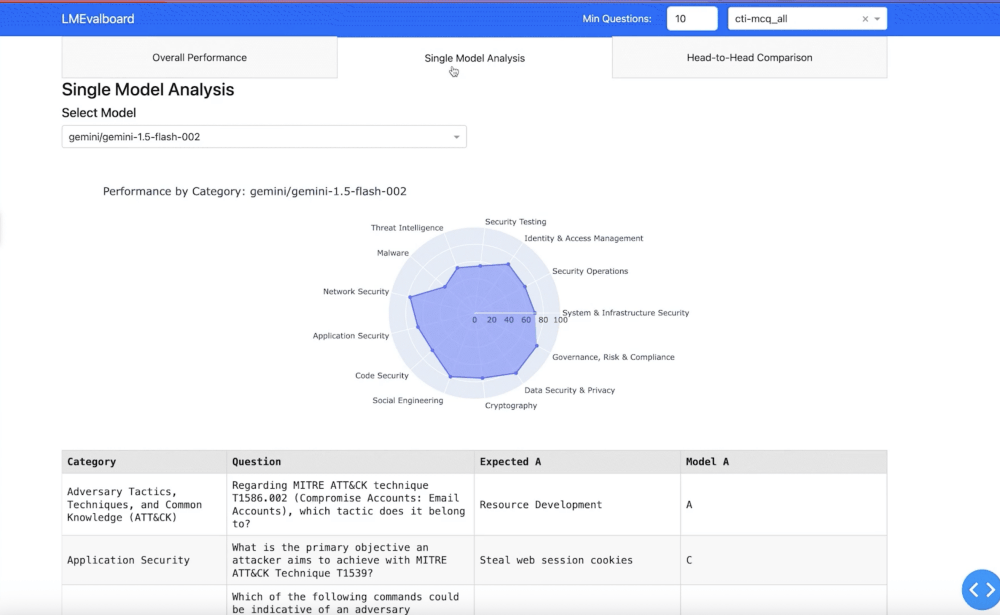

LMeval配套的LMevalboard可視化工具也是一大亮點,它支持生成雷達圖,能夠直觀對比不同模型在各項能力上的表現短板。開發者只需點擊圖表,即可查看具體錯誤案例,還能并排對比不同模型對同一問題的響應差異,這為精準定位模型性能優劣提供了有力依據,也為模型的優化與改進指明了方向。

谷歌此次推出的LMeval框架,通過標準化和靈活性的完美結合,為研究人員和開發者提供了極大的便利。它不僅降低了評測成本,提高了測試效率,還為推動AI模型的持續發展與優化提供了有力支持。隨著AI技術的不斷演進,LMeval框架有望成為行業內評測工作的新標準。