英偉達AI總監Jim Fan在紅杉AI Ascent大會上分享了關于具身智能未來的核心挑戰和解決方案。Fan指出,盡管大語言模型已經突破了傳統的圖靈測試,但機器人在物理世界中的表現仍遠未達到人類水平。其中,數據成為了制約機器人發展的最大瓶頸。

Fan解釋說,機器人需要物理交互的真實數據,這些數據無法從網頁上抓取,只能通過人類手動采集,效率極低。為了應對這一挑戰,英偉達團隊提出了在仿真世界中尋找解決方案。通過超高速仿真技術,機器人可以在2小時內完成相當于現實世界10年的訓練量,并將這些知識無縫遷移到物理世界。

Fan進一步指出,生成式AI技術,如3D生成和紋理生成,將進一步降低仿真訓練對人工數據的依賴。當視頻生成模型構建的虛擬世界逐漸成型時,機器人將能夠在無限可能的“夢境空間”中訓練,不僅成本極低,還能通過提示詞自由創造反事實的訓練場景,從而拓寬機器人的能力邊界。

Fan在演講中提出了“物理圖靈測試”的概念,即機器人能否在物理世界中完成任務,以至于人類無法區分這是人類還是機器人的勞動成果。他強調,目前機器人還遠未達到這一標準,例如人形機器人和機器狗在實際操作中仍頻繁出錯。

Fan和英偉達團隊認為,仿真技術是推動機器人技術發展的關鍵。通過構建數字孿生,即機器人和世界的1:1副本,在仿真世界中訓練,然后在真實世界中測試,可以大大加速機器人的學習過程。Fan展示了在仿真世界中訓練機器人在瑜伽球上行走,然后將其遷移到真實世界的成功案例。

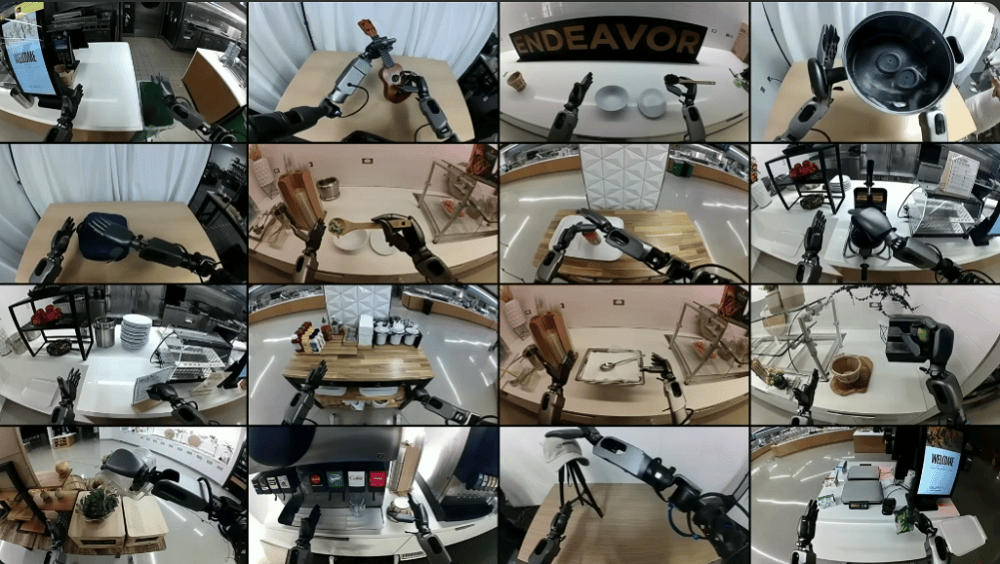

Fan還介紹了英偉達開發的大規模仿真平臺RoboCasa,該平臺除了機器人本體之外,所有視覺元素都是由AI生成的。通過RoboCasa,操作者可以在虛擬環境中進行遙操作,系統可以回放仿真軌跡,并利用硬件加速的射線追蹤技術呈現逼真的光影效果。

Fan指出,未來世界模型與仿真技術的深度融合將推動機器人技術進入“仿真2.0”時代。視頻生成模型的出現,使得仿真技術不再依賴于繁瑣的人工建模,而是能夠自動生成復雜場景和物體。這種“數字游民”式的仿真,將漫游進視頻擴散模型的夢境空間,為機器人提供無限可能的訓練環境。

Fan最后表示,物理AI的下一個前沿將是“物理API”的革命。就像今天的大模型API處理數字信息一樣,物理API將能夠操控物理世界的物質變化。這將催生全新的經濟形態,如“物理App Store”和“技能經濟”,機器人將逐漸融入生活背景,成為環境智能的一部分。