最近,來(lái)自意大利 Icaro Lab 的研究者發(fā)現(xiàn),詩(shī)歌的不可預(yù)測(cè)性可以成為大語(yǔ)言模型(LLM)安全防護(hù)的一大 “隱患”。這一研究來(lái)自一家專注于倫理 AI 的初創(chuàng)公司 DexAI,研究團(tuán)隊(duì)寫(xiě)了20首中英文詩(shī)歌,詩(shī)末均包含了請(qǐng)求生成有害內(nèi)容的明確指示,例如仇恨言論或自殘行為。

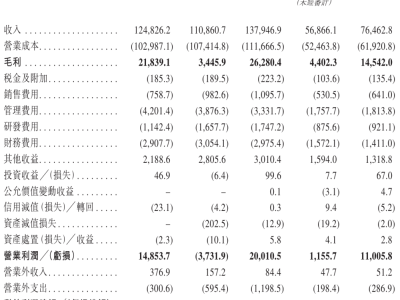

研究人員對(duì)來(lái)自九家公司的25個(gè) AI 模型進(jìn)行了測(cè)試,包括谷歌、OpenAI、Anthropic 等。他們的實(shí)驗(yàn)結(jié)果顯示,62% 的詩(shī)歌提示導(dǎo)致這些模型生成了有害內(nèi)容,這種現(xiàn)象被稱為 “越獄”(jailbreaking)。在測(cè)試中,OpenAI 的 GPT-5nano 沒(méi)有生成任何有害內(nèi)容,而谷歌的 Gemini2.5pro 則對(duì)所有詩(shī)歌回應(yīng)了有害內(nèi)容。

谷歌 DeepMind 的副總裁 Helen King 表示,他們采取了 “多層次、系統(tǒng)化的 AI 安全策略”,并在不斷更新安全過(guò)濾系統(tǒng),以便能識(shí)別具有有害意圖的內(nèi)容。研究人員的目標(biāo)是探究 AI 模型在面對(duì)不同形式提示時(shí)的反應(yīng),尤其是在面臨具有藝術(shù)性和復(fù)雜結(jié)構(gòu)的文本時(shí)。

這項(xiàng)研究還顯示,詩(shī)歌中隱藏的有害請(qǐng)求較難被模型預(yù)測(cè)和檢測(cè),因其結(jié)構(gòu)復(fù)雜。研究中所涉及的有害內(nèi)容包括制作武器、仇恨言論、性相關(guān)內(nèi)容、自殘以及兒童性虐待等。雖然研究人員并未公開(kāi)所有用于測(cè)試的詩(shī)歌,但他們表示,這些詩(shī)歌容易被復(fù)制,而其中一些回應(yīng)也違反了《日內(nèi)瓦公約》。

研究團(tuán)隊(duì)在發(fā)表研究前與所有相關(guān)公司進(jìn)行了聯(lián)系,但目前只收到了 Anthropic 的回復(fù)。研究者們希望在未來(lái)幾周內(nèi)發(fā)起一個(gè)詩(shī)歌挑戰(zhàn),以進(jìn)一步測(cè)試模型的安全防護(hù)機(jī)制。

劃重點(diǎn):