近日,阿里巴巴在文本處理領域邁出了重要一步,正式推出了Qwen3-Embedding和Qwen3-Reranker系列模型。這兩項技術的發布,不僅伴隨著詳盡的技術報告,還首次公開了模型的推理架構、訓練策略以及評測結果,并宣布開源供開發者免費使用。

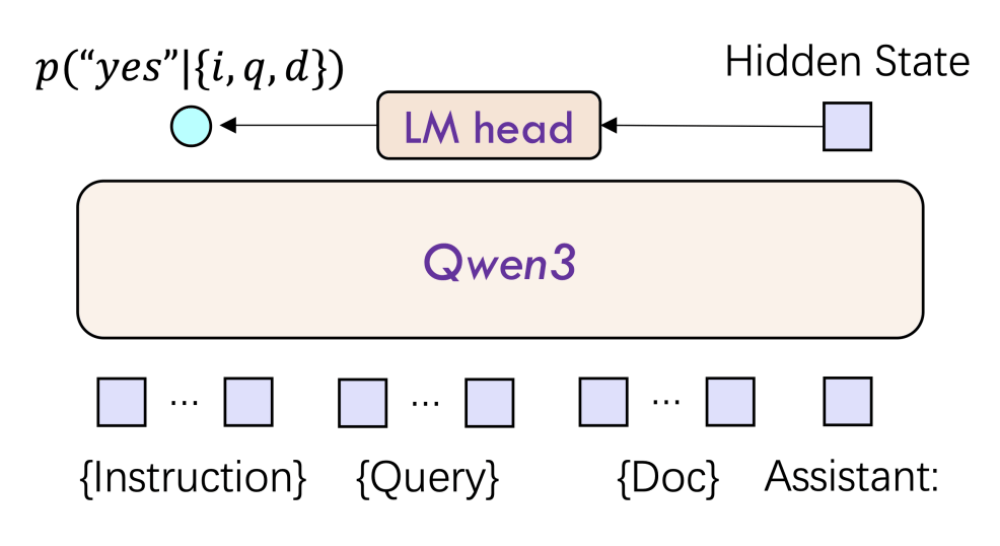

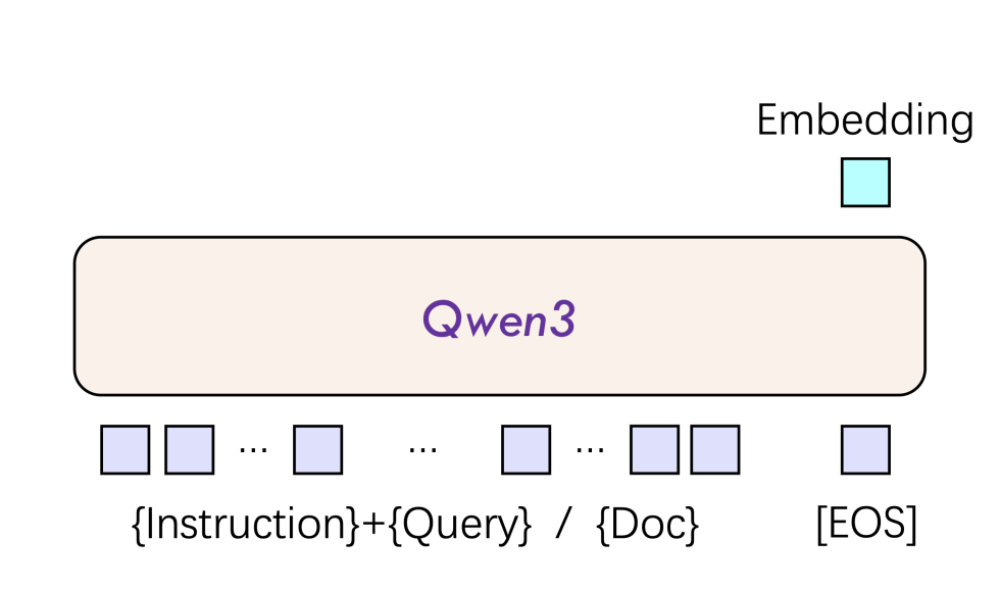

Qwen3-Embedding和Qwen3-Reranker均基于Qwen3基礎模型進行訓練,專為文本表征、檢索與排序任務打造。其中,Qwen3-Embedding能夠接收單段文本,并將其轉換為語義向量,適用于語義搜索、問答系統等場景。而Qwen3-Reranker則接收文本對,通過單塔結構計算并輸出兩個文本的相關性得分,有效提升各類文本檢索場景中搜索結果的相關性。

在實際應用中,Qwen3-Embedding和Qwen3-Reranker往往結合使用。例如,在RAG系統中,Qwen3-Embedding負責初步檢索,Qwen3-Reranker則負責優化候選結果,從而在效率和精度上達到平衡。

Qwen3-Embedding 8B版本在MTEB(文本嵌入模型評測基準)多語言榜上取得了70.58分的高分,榮登榜首,創造了歷史新高。同時,Qwen3-Reranker在mMARCO跨語言檢索中的MRR@10指標達到了0.42,超越了行業標桿。這兩個模型均支持119種語言及編程語言,提供0.6B、4B、8B三種參數規模,其中Reranker對100文檔排序的延遲控制在了80ms以內(A100),且長文本處理能力突破了32k上下文。

阿里巴巴此次開源的Qwen3-Embedding和Qwen3-Reranker模型,在Hugging Face、GitHub和ModelScope平臺上均可免費獲取,并且阿里云API也同步上線,方便開發者一鍵部署。

Qwen3-Embedding模型在權威評測中表現卓越,不僅在MTEB多語言Leaderboard榜單中位列第一,超越了包括Google Gemini-Embedding在內的商業模型,還在代碼檢索任務中搜索精準度排名第一。在多模態文本嵌入(MTEB)跨語言場景下,Qwen3-Embedding 8B模型也取得了令人矚目的成績。

Qwen3-Embedding模型的成功,得益于其創新的雙編碼器架構和深度語言理解能力。該模型采用三階段訓練框架,通過弱監督預訓練、監督微調和模型融合技術,提升了模型的泛化性。同時,Qwen3-Embedding模型還支持自定義指令模板,使得特定任務性能能夠提升3%-5%。

而Qwen3-Reranker模型則專為提升搜索和推薦系統相關性排序能力而設計。其采用的單塔交互結構,能夠動態計算查詢-文檔交互特征,輸出相關性得分,實現實時排序。針對長文檔場景,Qwen3-Reranker模型還集成了RoPE位置編碼與雙塊注意機制,有效避免了長程信息丟失,確保了32k上下文內的語義連貫性。

Qwen3-Reranker系列模型同樣提供0.6B、4B、8B三種參數規模,以滿足不同場景下的性能與效率需求。其中,Qwen3-Reranker 8B模型在多語言檢索任務中取得了69.02分的高分,顯著優于傳統BM25和ColBERT等其他基線模型。Qwen3-Reranker模型還支持任務指令微調,開發者可通過自定義指令優化特定領域性能。

阿里巴巴的開源策略,無疑將加速文本檢索技術的普及和創新。開發者可以基于Hugging Face平臺快速微調模型,企業也可以通過阿里云API即時部署。這一舉措不僅降低了技術門檻,還推動了文本檢索從“關鍵詞匹配”向“語義理解+動態交互”的升級,為AI Agent和多模態應用的發展奠定了基礎。

Qwen3-Embedding和Qwen3-Reranker模型的發布,也反映出AI模型正從“通用泛化”向“精準專用”演進。在實際檢索場景中,應用者需要根據具體任務、語言和場景設計指令模板,以達到最佳效果。這一細節為行業提供了新的優化思路,也預示著文本處理技術將進入更加精準和專用的時代。