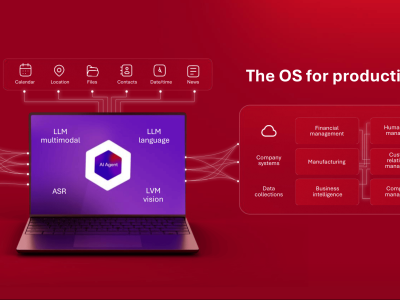

紅帽公司近期揭曉了其最新力作——紅帽AI推理服務(wù)器,該產(chǎn)品旨在混合云環(huán)境中為用戶提供兼具高效與經(jīng)濟性的AI推理解決方案。通過融合尖端的vLLM技術(shù)和Neural Magic的創(chuàng)新優(yōu)勢,紅帽力圖在響應(yīng)速度和性能表現(xiàn)上為用戶帶來顯著提升。

這款專為高性能打造的開放推理解決方案,內(nèi)置了一系列尖端的模型壓縮與優(yōu)化工具。紅帽將vLLM的前沿創(chuàng)新與其企業(yè)級能力巧妙結(jié)合,賦予用戶多樣化的部署靈活性。用戶不僅可以選擇將其作為獨立的容器化產(chǎn)品部署,還能輕松將其與紅帽企業(yè)Linux(RHEL AI)和紅帽O(jiān)penShift AI集成。

紅帽AI推理服務(wù)器能夠在不同部署環(huán)境中為用戶提供經(jīng)過強化的vLLM發(fā)行版。其核心功能之一是智能LLM壓縮工具,該工具能大幅縮減基礎(chǔ)AI模型和微調(diào)AI模型的大小,同時確保模型準(zhǔn)確性不受影響,并最大限度降低計算資源消耗。紅帽還提供了一個經(jīng)過優(yōu)化的模型存儲庫,該存儲庫托管在紅帽AI組織的Hugging Face平臺上,用戶可即時訪問經(jīng)過驗證的AI模型。這些優(yōu)化后的模型在推理部署中能顯著提升效率,效率提升幅度可達2至4倍,且不影響模型準(zhǔn)確性。

紅帽憑借多年將社區(qū)項目推向生產(chǎn)環(huán)境的豐富經(jīng)驗,為用戶提供強大的企業(yè)支持。同時,紅帽AI推理服務(wù)器還支持在非紅帽Linux和Kubernetes平臺上的靈活部署,為用戶在選擇部署環(huán)境時提供了更多自由。

紅帽AI業(yè)務(wù)部門副總裁Joe Fernandes指出:“推理是生成式AI的核心價值所在,它使模型在用戶互動時能迅速給出準(zhǔn)確回應(yīng)。我們的目標(biāo)是高效且經(jīng)濟地滿足大規(guī)模推理需求。”紅帽AI推理服務(wù)器的推出,為用戶提供了一個通用的推理層,支持在不同環(huán)境中運行各類加速模型。