英偉達近期在人工智能領域邁出重要一步,推出了一款名為Describe Anything 3B(簡稱DAM-3B)的創新模型,專為解決圖像和視頻中特定區域的詳細描述難題而設計。

傳統的視覺-語言模型(VLMs)在概括整體圖像內容方面表現出色,但當需要針對圖像或視頻的某個特定區域進行細致描述時,往往力不從心。特別是在處理視頻時,由于需要考慮時間動態因素,這一挑戰更為顯著。

英偉達推出的DAM-3B模型,正是為了解決這一痛點而生。用戶可以通過簡單的點擊、繪制邊界框、涂鴉或使用掩碼等方式,指定圖像或視頻中的目標區域,DAM-3B便能生成精準且符合上下文環境的描述文本。該模型分為兩個版本:DAM-3B適用于靜態圖像,而DAM-3B-Video則專門用于處理動態視頻。

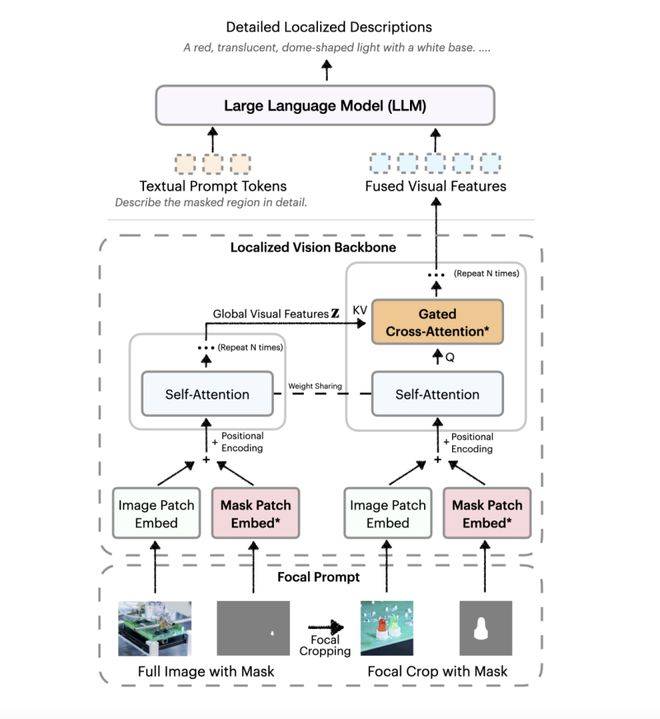

DAM-3B的核心創新在于其獨特的“焦點提示”技術和“局部視覺骨干網絡”。焦點提示技術結合了全圖信息與目標區域的高分辨率細節,確保在保留整體背景的同時,不丟失任何關鍵細節。而局部視覺骨干網絡則通過嵌入圖像和掩碼輸入,運用先進的門控交叉注意力機制,巧妙地將全局與局部特征融合在一起,再傳遞給大語言模型以生成描述。

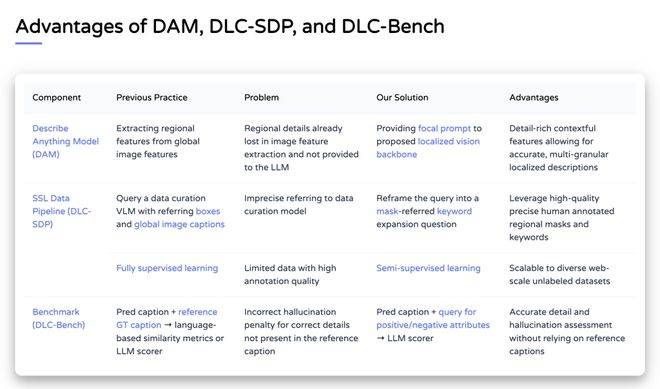

為了克服訓練數據匱乏的難題,英偉達開發了一套名為DLC-SDP的半監督數據生成策略。該策略利用現有的分割數據集和未標注的網絡圖像,構建了一個包含150萬局部描述樣本的龐大訓練語料庫。通過自訓練方法,英偉達不斷優化描述質量,確保輸出文本的高精準度。

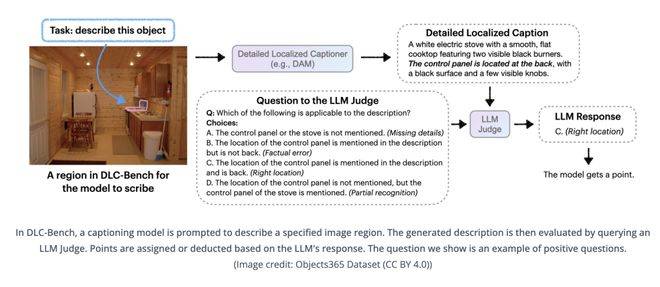

為了評估DAM-3B的性能,英偉達推出了DLC-Bench評估基準。這一基準不再僅僅依賴于僵硬的參考文本對比,而是以屬性級正確性來衡量描述質量,從而更準確地反映模型的實際表現。

在包括LVIS、Flickr30k Entities等在內的七項基準測試中,DAM-3B均取得了領先成績,平均準確率高達67.3%,超越了GPT-4o和VideoRefer等其他先進模型。這一卓越表現,不僅填補了局部描述領域的技術空白,還為無障礙工具、機器人技術及視頻內容分析等領域帶來了全新的可能性。

英偉達的這一創新成果,無疑將在人工智能領域掀起新的波瀾,推動相關技術的進一步發展與應用。