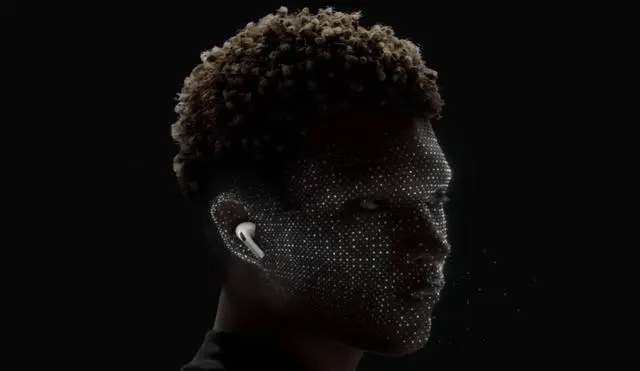

自2016年橫空出世,AirPods憑借其革命性的無線設計,迅速躍升為全球用戶心中的“科技新寵”。從最初的簡潔便捷,到后來陸續引入的主動降噪、透明模式、空間音頻及對話感知功能,AirPods不斷突破自我,逐漸演變為“耳朵上的智能伴侶”。

據可靠消息,即將問世的iOS 19系統將再次為AirPods注入新鮮血液——實時翻譯功能。這一消息源自彭博社知名記者馬克·古爾曼的爆料,蘋果正計劃將實時翻譯技術融入AirPods,為用戶帶來前所未有的溝通體驗。

想象一下,當一位中文用戶身處英語交流的環境中,只需佩戴AirPods,iPhone便能實時捕捉并翻譯對方的話語,隨后通過耳機以中文形式清晰傳達。同樣,當用戶想要回應時,iPhone也能將中文翻譯成英文并即時播放,確保雙方溝通無阻。這一功能不僅免去了掏出手機查看屏幕的繁瑣,更讓雙手和視線得以自由,讓交流更加自然流暢。

盡管目前尚未明確具體適配的AirPods型號,但古爾曼暗示,至少部分現有型號(如AirPods Pro 2)有望支持這一功能。當然,也存在蘋果將完整體驗鎖定在未來發布的AirPods Pro 3及其全新H3芯片上的可能性,以充分發揮其強大的算力優勢。

要實現“耳機實時翻譯”,蘋果需克服諸多技術難題。這包括在嘈雜環境下準確捕捉語音的語音識別技術(ASR),理解語境、口音、方言等多樣化表達的自然語言理解技術(NLU),以及幾乎無縫地將源語言轉譯成目標語言并迅速播放的低延遲翻譯技術。然而,從蘋果在Siri、空間音頻、主動降噪等領域的深厚積累來看,其具備推動這一技術落地的強大實力。

實時翻譯功能的應用場景遠不止出國旅游。在國際商務交流、跨國公司合作、留學生活等多語言環境中,它都能成為用戶日常溝通的重要輔助工具。更重要的是,它賦予了用戶佩戴AirPods的全新理由,使AirPods從單純的“播放設備”進化為“聽覺信息接口”,進一步加深了用戶對蘋果生態的依賴。

近年來,類似的技術趨勢已初見端倪。骨傳導耳機強調開放聆聽與信息輔助,OpenAI、字節跳動、科大訊飛等公司也在探索將語音助手與耳機深度結合。而蘋果的做法顯然更具系統性,通過iPhone、AirPods、Apple Watch等設備的協同工作,構建了一個圍繞人耳的隱形交互圈。隨著語音識別、機器翻譯、情緒感知等技術的不斷成熟,AirPods有望成為我們最自然的AI助理,聽得見、說得出、響應快。

回顧AirPods的發展歷程,從無線音頻到主動降噪,再到對話感知和即將實現的實時翻譯,每一次迭代都不僅僅是功能的增加,更是與用戶連接方式的深刻變革。實時翻譯功能的加入,無疑將讓更多人重新審視耳機的價值,它不僅是音樂的載體,不僅是通話的工具,更是跨越語言障礙的橋梁。

至于最終體驗如何,還需等待iOS 19正式發布后才能揭曉。但可以預見的是,未來佩戴AirPods,將不再僅僅是為了聆聽熟悉的聲音,更是為了理解和融入世界上更多不同的聲音。