近期,科技界迎來了一項新的突破,谷歌DeepMind團隊推出了名為QuestBench的新基準,旨在評估大型語言模型(LLMs)在推理任務中識別和獲取缺失信息的能力。這一創新工具通過約束滿足問題(CSPs)框架,為LLMs在信息不完備場景下的應用提供了更為精確的衡量標準。

在現實世界中,無論是用戶提出數學問題時的信息遺漏,還是自主系統在部分可觀測環境中工作時的挑戰,都凸顯了理想化完整信息設定與現實問題之間的矛盾。這一矛盾促使LLMs必須發展出主動信息獲取的能力,以應對復雜多變的應用場景。

QuestBench基準的推出,正是為了解決這一難題。它專注于評估LLMs在推理任務中識別缺失信息的能力,將問題形式化為約束滿足問題,并特別關注“1-sufficient CSPs”,即那些只需知道一個未知變量值即可解決目標變量的問題。這一框架不僅覆蓋了邏輯推理、規劃和小學數學等多個領域,還通過變量數量、約束數量、搜索深度和暴力搜索所需猜測次數等四個難度軸,精準揭示了模型的推理策略和性能瓶頸。

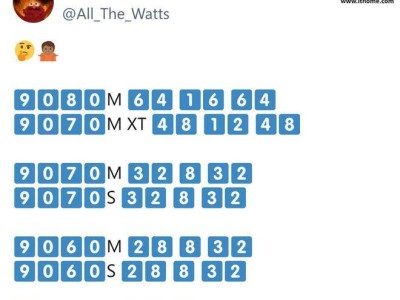

為了全面評估QuestBench基準的有效性,研究者們對包括GPT-4o、Claude 3.5 Sonnet、Gemini 2.0 Flash Thinking Experimental等在內的多個領先模型進行了測試。測試覆蓋了零樣本、思維鏈和四樣本設置,涉及了288個GSM-Q和151個GSME-Q任務,時間跨度從2024年6月至2025年3月。

測試結果表明,思維鏈提示在提升模型性能方面發揮了重要作用。在規劃任務中,Gemini 2.0 Flash Thinking Experimental模型表現尤為突出。然而,盡管開源模型在邏輯推理方面具有一定的競爭力,但在面對復雜數學問題時,其表現卻不盡如人意。研究指出,當前模型在簡單代數問題上尚能應對,但隨著問題復雜性的增加,其性能顯著下降,這凸顯了在信息缺口識別和澄清能力上的巨大改進空間。

QuestBench基準還揭示了不同模型在不同難度軸上的表現差異。例如,在某些變量數量較多、約束條件復雜的問題上,某些模型可能表現出更高的搜索深度和更強的猜測能力,而在其他情況下,則可能因缺乏足夠的信息而陷入困境。這些發現為未來的模型優化和算法改進提供了寶貴的參考。

QuestBench基準的推出不僅為LLMs在信息不完備場景下的應用提供了新的衡量標準,也為未來的模型優化和算法改進指明了方向。隨著技術的不斷進步和應用的日益廣泛,我們有理由相信,LLMs將在更多領域展現出其強大的推理能力和應用價值。