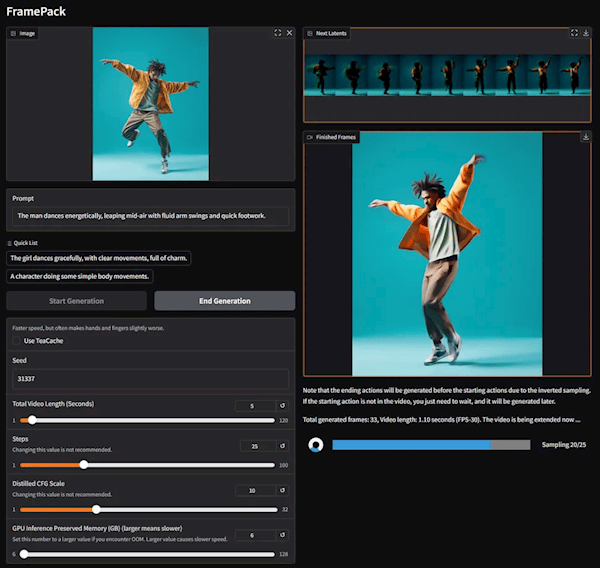

近日,GitHub平臺上的Lvmin Zhang與斯坦福大學的研究者Maneesh Agrawala攜手,推出了一項名為framePack的創新技術,該技術在視頻擴散模型中融入了固定長度的時域上下文機制,使得生成長時長、高質量視頻的效率顯著提升。

經過實際測試,基于framePack架構、擁有130億參數的模型,僅需配備6GB顯存的顯卡,便能輕松生成長達60秒的視頻內容。這一突破性進展,無疑為視頻生成領域帶來了全新的可能性。

framePack作為一種先進的神經網絡架構,采用了多級優化策略,實現了本地AI視頻的高效生成。值得注意的是,盡管其底層基于定制版的騰訊混元模型構建,但現有的預訓練模型同樣可以通過framePack進行微調與適配,大大拓寬了其應用范圍。

傳統的視頻擴散模型在生成視頻時,需要逐步處理帶有噪音的幀,并預測下一個噪音減少的幀。這一過程中,每生成一幀所需輸入的幀數量,即時域上下文長度,會隨著視頻長度的增加而不斷增加,對顯存提出了極高的要求。通常而言,至少需要12GB的顯存才能勉強應對,顯存不足則會導致視頻生成時間短、質量差、耗時長等問題。

相比之下,framePack通過智能評估輸入幀的重要性,對所有幀進行壓縮處理,將其轉化為固定的上下文長度,從而顯著降低了對顯存的需求。這一創新使得framePack的視頻生成計算消耗與圖片擴散模型相當,更加高效節能。同時,每一幀畫面生成后都會實時呈現,為用戶提供了便捷的即時預覽體驗。

framePack還有效緩解了視頻生成中的“漂移”現象,即隨著視頻長度的增加,質量逐漸下降的問題。通過framePack技術,可以在不顯著犧牲視頻質量的前提下,生成更長的視頻內容,滿足用戶對高質量長視頻的迫切需求。

在數據格式與硬件支持方面,framePack表現出色。它支持FP16、BF16等數據格式,兼容RTX 50、RTX 40、RTX 30系列顯卡(除RTX 3050 4GB外),幾乎涵蓋了所有近代顯卡。然而,對于RTX 20系列及更老的顯卡,以及AMD、Intel處理器的需求,framePack尚未進行驗證。

操作系統方面,framePack支持Windows和Linux兩大主流平臺,為用戶提供了靈活的選擇空間。在性能方面,經過teacache優化的RTX 4090顯卡,每秒可生成約0.6幀視頻內容,展現了framePack技術的強大實力。