DeepSeek團隊近期在Hugging Face這一知名AI開源社區上,震撼發布了一款全新數學模型——DeepSeek-Prover-V2-671B。這款模型不僅在參數規模上達到了驚人的6710億,更是在技術層面實現了諸多突破。

據悉,DeepSeek-Prover-V2-671B采用了更為高效的safetensors文件格式,這一改進使得模型在訓練和部署過程中能夠顯著節省資源,同時提升速度。該模型還支持多種計算精度,為用戶提供了更加靈活的選擇。

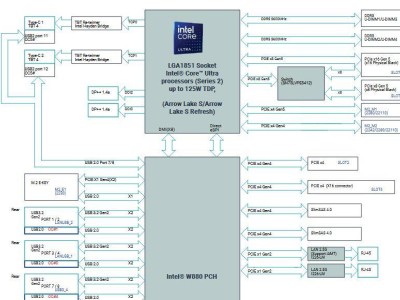

在模型架構方面,DeepSeek-Prover-V2-671B引入了DeepSeek-V3架構,并創新性地采用了MoE(混合專家)模式。這一架構包含了61層的Transformer層,以及高達7168維的隱藏層,使得模型在處理復雜任務時能夠展現出更強的能力。

尤為DeepSeek-Prover-V2-671B還支持超長上下文處理,其最大位置嵌入達到了16.38萬。這一特性使得模型在數學證明等復雜邏輯處理任務中能夠游刃有余,展現出卓越的性能。

DeepSeek團隊還為這款模型引入了FP8量化技術。通過這一技術,模型的大小得到了有效減小,同時推理效率也得到了顯著提升。這一改進不僅降低了模型的運行成本,還進一步拓寬了其應用場景。

據了解,DeepSeek-Prover-V2-671B或可視為去年發布的Prover-V1.5數學模型的升級版本。在保持原有優勢的基礎上,新版本在性能和技術層面均實現了顯著提升,為用戶提供了更加強大、高效的數學處理工具。

DeepSeek團隊的這一創新成果,無疑將為AI領域注入新的活力。隨著技術的不斷進步和應用場景的不斷拓展,DeepSeek-Prover-V2-671B有望在更多領域發揮重要作用,為人類社會帶來更加智能、高效的解決方案。