傳統檢測方法主要依賴尋找AI生成圖像中的技術痕跡,如頻域異常或像素級不一致性。這些方法在早期GAN生成圖像檢測中表現良好,但隨著生成技術進步,其局限性日益凸顯。更嚴峻的是,這些檢測器在面對精心設計的對抗性攻擊時幾乎完全失效,實驗數據顯示,某些檢測器的準確率在遭受攻擊后從83.90%驟降至1.75%,這種崩潰式失效暴露了現有技術的根本缺陷。

系統工作原理包含四個關鍵維度:首先是像素級保真度分析,使用峰值信噪比量化細節差異;其次是結構相似性評估,關注邊緣、紋理等結構特征;第三是感知距離測量,采用LPIPS指標模擬人類視覺判斷;最后是語義一致性檢驗,通過CLIP模型評估圖像講述的故事是否一致。這些多維度的分析結果被綜合為0到1之間的真實性指數,數值越接近1表示圖像越可能是真實的。

為確保判斷的可靠性,研究團隊建立了嚴格的標準體系。安全閾值設定為假陽性率不超過1%,即在100張真實圖像中最多允許1張被誤判。針對對抗性攻擊,系統還設計了更嚴格的安全防護閾值。實驗表明,不同AI生成模型需要不同的判別標準,例如Stable Diffusion 2.1模型的安全閾值為0.015,而更新的Stable Diffusion 3模型則提高到0.0368。這種差異反映了不同生成器的技術特征。

在抗攻擊能力測試中,新系統表現出顯著優勢。當傳統檢測器在遭受對抗性攻擊后準確率幾乎歸零時,真實性指數系統仍能維持合理判別能力。其關鍵在于系統不依賴固定特征模式,而是基于生成過程的內在復雜性。即使攻擊者對圖像進行微小修改,也難以同時操控視覺外觀和重現難度這兩個相互制約的特性。

研究團隊還將方法擴展到視頻內容驗證領域。對于輸入視頻,系統均勻選取8個關鍵幀進行獨立分析,然后通過平均幀得分獲得視頻級評估。在Deepfake-eval-2024基準測試中,該方法展現出穩定性能:真實視頻通常比虛假視頻更難重現,因此獲得更高真實性指數。雖然當前方法未充分利用時序信息,但已證明核心原理在視頻領域同樣適用。

大規模社交媒體內容分析揭示了令人深思的現象:在約3000張真實圖像中,能被確認為"可驗證真實"的比例隨著生成技術進步急劇下降。使用Stable Diffusion 2.1模型時,有1116張圖像被標記為真實;而使用更先進的FLUX模型時,這個數字降至55張。這表明隨著AI生成能力提升,真實內容開始具有"可被質疑"的特征,我們正在進入"真實性稀缺"的時代。

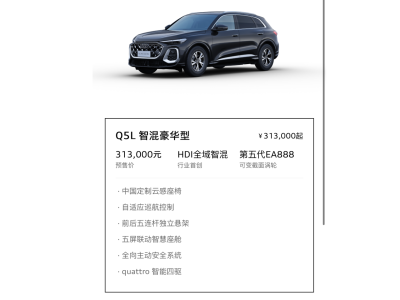

進一步分析發現,包含精細紋理、復雜光影和自然遮擋的圖像更難被重現,因此更可能被標記為真實;而構圖簡潔、光照均勻的圖像則更容易被歸類為"存疑"。這種模式反映了當前AI生成技術的能力邊界——雖然能生成清晰美觀的圖像,但在處理真實世界的復雜性和隨機性方面仍存在局限。不過隨著技術進步,這些邊界正在快速推移。

與傳統方法相比,新系統在可靠性和抗攻擊能力方面優勢顯著。其零樣本泛化能力表現出色,無需針對特定虛假內容訓練即可準確識別。系統主要依賴預訓練模型和標準化相似性度量,部署成本較低且透明度高。每個判斷都基于可量化的相似性指標,用戶可以理解系統做出判斷的依據,這對于新聞驗證等需要高度信任的場景尤為重要。

這項研究為數字內容真實性驗證提供了實用工具,其價值不僅在于技術突破,更在于應對社會信任挑戰。在真假界限日益模糊的數字世界中,該系統能幫助公眾獲得內容的可信度評估,標識出"存疑"信息,培養更理性的信息消費習慣。雖然系統仍存在需要訪問高質量生成模型等局限性,但其驗證思路為維護數字媒體可信度提供了重要方向。對于希望深入了解技術細節的讀者,可通過論文編號arXiv:2512.15182v1查詢完整研究內容。