7月10號,MiniMax面向全球舉辦了M1技術(shù)探討會。作為中國團隊,我們很高興組織發(fā)起與全球?qū)W者的開放技術(shù)探討。現(xiàn)場,來自十幾個國家地區(qū)的觀眾從世界各地加入,與M1團隊和全球?qū)W者進行了技術(shù)交流。

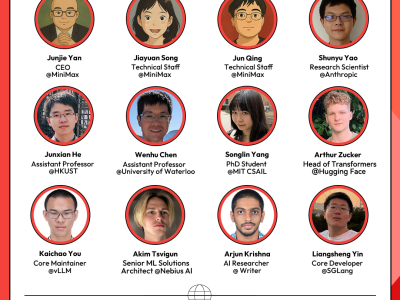

M1團隊與來自香港科技大學、滑鐵盧大學、Anthropic、Hugging Face、SGLang、vLLM、RL領(lǐng)域的研究者及業(yè)界嘉賓在模型架構(gòu)創(chuàng)新、RL訓練、長上下文應(yīng)用等領(lǐng)域探討了當前的前沿話題。嘉賓詳見:

秉承開源精神,我們將本場探討會的技術(shù)觀點分享出來,以下是要點總結(jié):

01

RL能否賦予模型新能力?

RL能否提升模型的基礎(chǔ)能力?很多人認為,RL只是在激活模型在預訓練階段就已經(jīng)學會的一些能力或技巧,不能夠讓模型從根本上學會預訓練階段不存在的新技能,例如有些論文說,RL并不能提高模型的pass@k。

首先需要定義模型的基礎(chǔ)能力。一個比較實用的定義是,對于給定的上下文長度,模型在一組特定問題上,在無限次嘗試下的通過率(pass@k, k→∞)是多少。如果這個通過率等于1,就表示這個模型能解決這類問題。如果通過率等于0,就表示模型解決不了。如果模型的生成長度,即模型思考過程的長度是無限的,RL什么也改變不了。根據(jù)定義,如果你有無限的上下文長度,那么所有能用自然語言表述的問題,理論上都可以通過有限次的采樣嘗試來解決。

如果針對一個有限上下文長度,RL是否能賦予模型新能力?答案是:能。因為RL所做的是改變模型輸出的分布。預訓練后,模型可能需要至少10W個token才能解決某個問題,但經(jīng)過RL微調(diào)后,它可能只需要10K個token。如果模型有限上下文長度是50K個token,那么RL的確賦予了模型新能力。

在有限上下文長度下, pass@k 是一個好的衡量指標。K的取值很重要,這取決于如何定義模型能力,如果定義是“模型至少有一次能解決這個問題”,那么應(yīng)該用盡可能大的k來衡量pass@k;但如果定義是“模型能否在4次嘗試內(nèi)解決問題”,那應(yīng)該去衡量 pass@4。

目前 Reward 是RL scaling 的核心瓶頸,特別是如何為那些不基于結(jié)果的獎勵(non-outcome-based reward)進行建模,這是全世界都還感到困惑的地方。比如,人類可以從別人寫的一段文字或反饋中獲得正面或負面的感受,但我們目前并沒有很好的方法來對這種主觀感受進行建模。

02

預訓練的價值在于更多樣化的數(shù)據(jù)分布

如何理解預訓練在RL過程中的角色?如果預訓練在某些技能,如編程或數(shù)學,上有所欠缺,后訓練階段僅憑RL能把這塊短板補上嗎?

原則上可以,只要有足夠的信息源,我們就可以用RL來替代任何過程。某種意義上,預訓練只是RL的一種特例。任何監(jiān)督學習都可以被看作是一種特殊的強化學習。現(xiàn)階段,RL訓練階段的數(shù)據(jù)分布,要遠比預訓練數(shù)據(jù)的分布狹窄得多。這正是目前進行預訓練能帶來的最大收益——它讓模型獲得了范圍遠為廣闊的知識。

但在當前階段,預訓練的價值在于,我們可以在預訓練階段接觸到更多樣化的數(shù)據(jù)分布。因為目前RL訓練數(shù)據(jù)的質(zhì)量要求門檻相當高,我們主要知道如何在有限的環(huán)境中擴展RL訓練,例如reward被清晰定義的環(huán)境。目前RL研究的核心挑戰(zhàn)之一是如何拓展至reward清晰的環(huán)境之外。獎勵建模(Reward Modeling)可能是一種解決方案,但更為通用的獎勵信號依然是行業(yè)在探索的方向。

03

只在數(shù)學和代碼上做RL訓練,更容易產(chǎn)生幻覺

關(guān)于通用推理,至少在今年二月左右,大多數(shù)RL數(shù)據(jù),都來自于數(shù)學或編程領(lǐng)域。而事實是,只在數(shù)學和代碼上進行RL訓練,模型更容易產(chǎn)生幻覺。在很多事實性基準,比如SimpleQA上的性能會顯著下降,甚至在像MMLU這樣的多學科問答基準上也會下降。

因此我們做通用推理數(shù)據(jù)集的一個動機,就是為了創(chuàng)建更多樣化的RL訓練數(shù)據(jù)。WebInstruct-verified旨在為所有領(lǐng)域構(gòu)建更大規(guī)模的RL訓練數(shù)據(jù),以便模型能夠在不同領(lǐng)域取得進步,而不僅是數(shù)學和編程。

現(xiàn)在我們甚至在嘗試進一步擴大這個規(guī)模。之前,通過在預訓練數(shù)據(jù)集中搜索可用的RL數(shù)據(jù)來擴大規(guī)模,我們成功地把它擴展到了50萬的量級。現(xiàn)在正嘗試通過檢索更大規(guī)模的預訓練數(shù)據(jù)集,從中獲取越來越多樣的RL數(shù)據(jù),并采用在mid-training進行RL的范式,而不僅僅是作為后訓練。

04

如何讓模型用圖像思考?

目前很多視覺推理范式,核心大都集中在文本形式的思維鏈上,而視覺部分固化為一個 ViT編碼器,沒法讓模型在編碼圖像上花費更多計算資源。而像 Pixel Reasoner 或其他一些工作,正試圖幫模型重新審視圖像的特定區(qū)域,并對其進行重新編碼,從而在關(guān)鍵區(qū)域上投入更多算力。

但這并不是一個非常本質(zhì)的提升模型能力的方法,在現(xiàn)階段更像是一個權(quán)宜之計。因為現(xiàn)有的視覺編碼器太弱了,無法很好地處理高分辨率圖像,所以才嘗試用zoom-in或其他操作來操縱圖像表示,然后從輸入中重新調(diào)用它,并在此基礎(chǔ)上進行推理。在現(xiàn)階段,大多數(shù)工具,比如zoom-in、重新調(diào)用幀或高亮顯示,實際上都只是在增強感知能力。

也存在一些更復雜的工具,能從根本上改變圖像,比如使用圖像生成技術(shù)。這種做法就已經(jīng)超越了單純增強感知的范疇,比如在幾何問題中畫輔助線。最近還沒太多這方面的成功案例,但如果有人能設(shè)法讓這種方法奏效,那它將是“用圖像思考”的一個更強大版本。

我們?nèi)匀恍枰鉀Q根本的瓶頸問題:如何更好地編碼視覺像素,以及如何以更好的方式在潛在空間(latent space)中進行視覺推理——注意,不是在實際的像素空間,而是在抽象的潛在空間。

Latent reasoning可能是一個非常好的機會。很多視覺推理,特別是在機器人或具身智能領(lǐng)域,真的需要在空間中思考。在這些涉及空間感的場景下,文本推理就不是一個好方法,很多推理過程是隱式的,無法被清晰地表述或言語化。

05

當前RL領(lǐng)域最令人興奮的挑戰(zhàn)

RL面臨挑戰(zhàn)之一,是Reward Modeling,特別是如何超越那些結(jié)果容易被評估的環(huán)境。這將會極大地擴展RL應(yīng)用場景。

另一個可能很重要的領(lǐng)域是多智能體。不過,多智能體目前更多受限于基礎(chǔ)設(shè)施,而非理論研究。對我來說,用一個中央模型調(diào)用子智能體和調(diào)用工具是同一回事,沒有區(qū)別。當我說“多智能體”時,腦海中想的更多的是一個包含多個AI模型、并且它們在訓練過程中相互交互的環(huán)境。

還有一個令人興奮的領(lǐng)域就是AI自動化研究——讓模型自己訓練自己。這其實一直以來都與AGI的定義相關(guān):當模型可以在沒有人類干預的情況下,自我訓練并自我提升。

還有剛剛提到的,非Token空間的推理,那里也存在著機會。

06

長上下文是Agent的Game changer

長上下文在Agent工作流中有巨大潛力。我們另一個客戶正在構(gòu)建復雜的智能體系統(tǒng),長上下文窗口對他們來說是真正的game-changer。Agent完成某個任務(wù)時,能夠?qū)⒄麄€代碼庫、API參考文檔、歷史交互數(shù)據(jù)等等,全部一次性喂給它。這種任務(wù)你不能分幾次調(diào)用來處理,因為當你讓智能體完成任務(wù)時,它掌握的關(guān)于這個項目的信息越多,產(chǎn)出的質(zhì)量就越高。

我們有望從目前在大多數(shù)情況下,只能處理相當孤立任務(wù)的智能體,發(fā)展到那些能夠管理復雜項目、同時保持完整上下文感知的智能體。

對于Nebuis的客戶,M1這樣超長上下文模型的真正價值在于解鎖了全新的企業(yè)級應(yīng)用場景。這些場景以前用分塊處理策略來解決,非常繁瑣,甚至幾乎不可能。

例如,一個法律行業(yè)客戶需要把文件一塊一塊地喂給大語言模型,并用一些竅門來優(yōu)化檢索和上下文管理。這樣問題在于,可能錯過埋藏在某個隨機法律文件某一頁中的關(guān)鍵細節(jié)。而有了1M token的上下文窗口,就可以一次性處理整個案件歷史、所有相關(guān)判例以及所有其他信息源,這無疑能提升了服務(wù)質(zhì)量。

Writer是一家服務(wù)于全球企業(yè)級客戶的公司,長上下文模型在企業(yè)級應(yīng)用需求非常廣泛。它被應(yīng)用得最多的領(lǐng)域之一是法律合規(guī)分析。比如,分析冗長的合同、電子健康記錄或公司年報,從中提取關(guān)鍵條款、識別風險,然后附上引文進行總結(jié),需要非常巨大的上下文窗口。另一個領(lǐng)域是客戶研究洞察。比如,總結(jié)大量的調(diào)查問卷回復或研究論文,以發(fā)現(xiàn)其中的主題,并提取一些見解。

長上下文模型也被大量用于收入與報告相關(guān)的業(yè)務(wù)。比如,錄入大量的項目招標書,從Salesforce中拉取數(shù)據(jù),然后自動起草第一版的回應(yīng);或者處理一些基金報告,這需要將內(nèi)部研究與第三方市場數(shù)據(jù)結(jié)合起來。還有技術(shù)支持與知識管理領(lǐng)域。這是每個開發(fā)者的負擔——對工單進行分類,更新內(nèi)容管理系統(tǒng),或者為已有的工作流發(fā)布內(nèi)容。要讓智能體在這個領(lǐng)域里運作,就需要長上下文能力。

07

混合架構(gòu)將成為主流

對比純線性注意力和Full Attention,混合注意力機制(Hybrid Attention)無疑是最有前景的方案。純線性注意力機制有很多根本性局限,因為它的狀態(tài)大小是固定的,因此,在處理長序列建模問題時表現(xiàn)不佳。而Full Attention雖然提供了靈活性,但其代價也顯而易見:KV緩存大小會隨著序列長度線性增長,并且訓練復雜度也是平方級的。當序列不斷變長時,高昂的推理和訓練復雜度就會成為瓶頸。將這兩種機制結(jié)合起來,也就顯得順理成章,混合模型(Hybrid Model)就應(yīng)運而生了。

混合架構(gòu)將會成為模型設(shè)計的主流,因為隨著對大規(guī)模部署和低延遲需求的增長,人們會越來越關(guān)心推理效率和模型的推理能力。MiniMax的模型也證明了這一點。至于如何進一步拓展混合注意力架構(gòu)的空間,未來的研究者需要思考,不能只是簡單地用固定的比例來交錯堆疊Softmax注意力和線性注意力層,也許需要更多樣的混合架構(gòu)形式。

脫離硬件的純粹算法研究,正逐漸失去關(guān)注度,尤其是在LLM領(lǐng)域。如果一項技術(shù)無法規(guī)模化,或者不能被高效地部署,那它就很難獲得關(guān)注、形成勢能。一個算法不僅要在理論上站得住腳,還必須在硬件上——尤其是在GPU或TPU這類加速器上高效運行。如今的算法研究者們已經(jīng),并且也應(yīng)當熟悉基本的硬件原理,比如內(nèi)存層級(memory hierarchy)、并行計算(parallelism)、共享內(nèi)存(shared memory)等等。他們還應(yīng)該去掌握一些底層的GPU編程工具,比如 Triton。這才是當今在LLM領(lǐng)域做算法研究的正確方向。

混合架構(gòu)目前的瓶頸在于基礎(chǔ)設(shè)施。混合模型的有效性在去年就已經(jīng)得到了很好的驗證,但沒有公司投入更多資金進行大規(guī)模驗證,直到 MiniMax 發(fā)布了他們的大模型 MiniMax Text-01,人們才意識到混合模型原來有這么大的潛力。當前算法層面已經(jīng)趨于穩(wěn)定了,我們應(yīng)該專注于為這些新機制構(gòu)建好的基礎(chǔ)設(shè)施。

08

混合架構(gòu)推理的前沿實踐

在推理層面,隨著混合注意力架構(gòu)越來越流行,為了在SGLang或其他推理引擎中充分利用緩存感知和緩存復用等特性,我們需要為普通架構(gòu)和混合架構(gòu)設(shè)計一個統(tǒng)一的抽象層,這樣才能簡單地將所有優(yōu)化應(yīng)用到混合模型上。

此外當前MiniMax模型這種7+1層交錯的架構(gòu)可能會帶來一些工程挑戰(zhàn),特別是在用計算圖優(yōu)化(Graph Optimization)進行部署時,因為不同層的計算和內(nèi)存訪問模式是不同的,這會導致GPU利用率不平衡。可能需要用一些技術(shù)來解決它,比如批處理重疊(batch overlapping)或者更先進的pipline策略。

從支持混合架構(gòu)的技術(shù)層面來說,首先需要一個混合分配器(hybrid allocator),這個功能在vLLM中已經(jīng)有了。它有助于管理混合架構(gòu)的KV緩存——盡管對于某些部分我們不稱其為KV緩存,但混合架構(gòu)中仍然存在某種形式的狀態(tài)。這些狀態(tài)的生命周期與全注意力層的KV緩存并不同步,所以需要設(shè)計如何讓它與現(xiàn)有的緩存機制、預填充、解碼等環(huán)節(jié)協(xié)同工作。

其次,批處理重疊(batch overlapping)會很有幫助。采用了混合架構(gòu)后,有些層是full attention,有些層只是簡單的線性注意力,這就存在計算不平衡。如果按順序計算,那么在計算線性注意力層時,計算資源可能就未被充分利用。但如果能將兩個微批次(micro-batches)重疊起來處理,只要比例計算得當,理論上任意時刻都會有一個微批次在執(zhí)行計算密集型的full attention 操作,從而最大化GPU利用率。

從生產(chǎn)部署的角度來看,混合架構(gòu)的推理速度對現(xiàn)實應(yīng)用至關(guān)重要。例如,有一個客戶,需要并發(fā)處理多個幾十萬token的請求。但對于使用二次方復雜度注意力的傳統(tǒng)模型,在這種輸入大小和并發(fā)量下,生成速度都會變得極慢。用 DeepSeeker-R1,在8個并發(fā)請求、每個請求10萬token的情況下,平均要等待大約1分鐘才能得到首個token。而用MiniMax的模型,大約是4到5秒,數(shù)字小了一個量級。這個速度完全可以接受,并且也為在生產(chǎn)負載下,用如此大的上下文進行在線應(yīng)用解鎖了可能性。

09

M1背后的Q&A

Q:混合線性注意力會如何影響使用RL的推理模型的性能?

A:在訓練過程中,當我們擴展到可處理數(shù)萬 token 上下文長度的模型時,遇到了重大問題:RL訓練停滯不前,獎勵信號在僅幾百步后就不再增長。研究后,我們發(fā)現(xiàn)問題在于,線性注意力架構(gòu)在這種規(guī)模下固有的訓練不穩(wěn)定性。這導致了一些問題,比如某些層激活值爆炸等,并使模型在訓練和推理時的行為出現(xiàn)了嚴重錯位。識別并修復了這個 bug 之后,我們才成功地使用RL訓練該模型。

這個問題,也使得我們發(fā)現(xiàn)混合線性注意力的一個根本性權(quán)衡:它效率極高,單位 token 的計算成本非常低,但通常需要生成更多的 token(即更長的推理路徑)才能達到與 full attention 模型相同的性能。然而,我們的工作證明了,通過適當規(guī)模的RL以及合適的推理時算力,混合注意力模型確實能媲美full attention架構(gòu)性能。

這對未來架構(gòu)設(shè)計的一個關(guān)鍵啟示,是評估方法的重要性。為了公平地比較混合模型與其他模型,我們應(yīng)該基于在給定任務(wù)下、固定總計算預算內(nèi)的性能來進行評估,而不僅僅是比較固定輸出長度下的效果。這提供了一個更全面、更能反映模型真實效率和能力的視角。

Q:推理模型是否已經(jīng)具備了System 2推理和自我反思能力?

A:System 2推理和自我反思,可以被理解為從大語言模型基本原理中涌現(xiàn)出的、可被觀測的模式。

首先其核心驅(qū)動力,是有效利用更大的計算資源,即更長的輸出,來獲得更好性能的能力。我們觀察到的高級推理能力,是擴展這些資源后的直接結(jié)果,而非其根本原因。本質(zhì)上,為模型提供更多的計算能力去“思考”,使得這些復雜的模式得以涌現(xiàn)。

其次,這種高級推理可以被看作是一種自動化的Prompt Engineering。對于數(shù)學或編程等復雜任務(wù),模型學會了生成自己的內(nèi)部思考過程,這實際上取代了人類提供詳盡、分步式指令的需要。

對于寫作等任務(wù),模型在思考過程中會先對問題進行分析,并對寫作步驟進行專業(yè)化拆解。它會獨立地執(zhí)行諸如規(guī)劃和對問題進行更深層次分析等操作。這使得模型能夠通過創(chuàng)建詳細推理路徑來“像專家一樣思考”。

因此 System2 推理和自我反思,實質(zhì)上是如何高效地利用并擴展計算預算(computation budget),同時也是模型自動深化用戶問題的體現(xiàn)。

自創(chuàng)立以來,MiniMax 即以“與所有人共創(chuàng)智能”為使命,致力于推動人工智能科技前沿發(fā)展,實現(xiàn)通用人工智能(AGI)。我們將繼續(xù)堅持做上限更高的事,堅持底層架構(gòu)和算法創(chuàng)新,與合作伙伴一起為全球開源社區(qū)持續(xù)貢獻。

Intelligence with Everyone