新智元報道

編輯:定慧

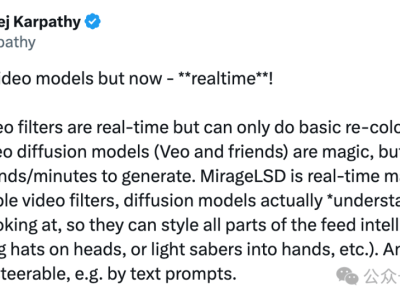

剛剛,世界上首個支持直播推流的「實時」擴散AI視頻誕生。

最火的「馬斯克AI女友」可以直接秒變哥特風格、卡哇伊風格——注意是實時,而不是后期生成。

這就是DecartAI最新推出的MirageLSD:首個支持直播推流的實時擴散AI視頻模型。

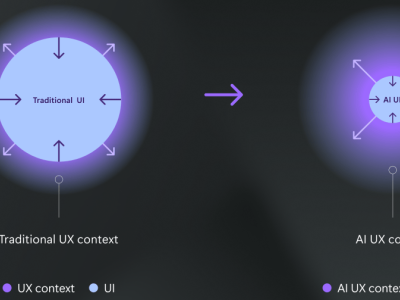

比如我們熟悉的濾鏡,就是一種實時視頻效果。

簡單的濾鏡效果雖然是「實時」的,但也只能進行基本的重新著色和樣式設置,本質上濾鏡是「無法理解」視頻內容的。

現在AI生成視頻常用的擴散模型,比如谷歌的Veo3,已經很神奇了,它是能夠「理解」想要生成的視頻內容的。

但是唯一的缺點是生成過程比較慢需要好幾分鐘,效果好的視頻需要時間更多。

MirageLSD則是一種完全不同的模型,它不是簡單的疊加濾鏡,而是理解真實視頻后同步生成無限想象力的AI視頻。

比如可以給你的狗穿上蜘蛛俠的衣服,或者將打斗場面直接變成星球大戰。

也可以把廚房的風格變換為卡通,或者直接將手里的筆變成光劍。

這些畫面都可以任意通過提示進行操控。

這給未來的視頻娛樂、直播互動帶來了豐富的想象力。

科幻片導演現場拍攝時,就可以直接測試成片的效果;

實時虛擬替換不同風格、不同背景下的衣服,比如直接穿著婚紗出現在禮堂;

例如情侶間通話時,將對話直接卡通化;

游戲畫面直接切換,比如直接將黑神話悟空切換到老頭環的交界地。

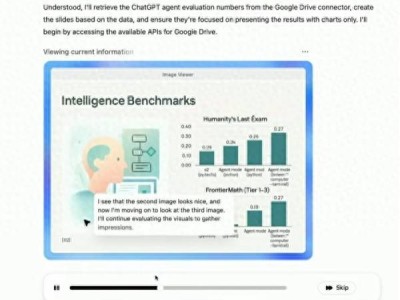

DecartAI給出幾個官方演示視頻,可以感受下這個「魔法般」的效果。

由于MirageLSD是實時運行,可以將游戲畫面實時設置為你最喜歡的場景。

另外一個最有趣的應用就是,不用再擔心直播設備不好,你可以直接將直播畫面轉化為全新場景,即使你的設備再差,也可以進行「完美直播」。

同時,Decart還提供了一個官方的體驗網站,不過現在估計熱度太高了,服務器一直無法連接。

本周上線的是網頁版,下周將上線iOS和安卓版本。

AI實時想象畫面

MirageLSD是首個實現無限、實時視頻生成且零延遲的系統。

它基于Decart自研的模型Live Stream Diffusion(LSD),能夠在保持時間連貫性的同時逐幀生成視頻。

與之前的方法不同,LSD支持完全交互式的視頻合成——在視頻生成的同時實現持續提示、變換和編輯。

當前的視頻模型在生成超過20-30秒的視頻時,會因誤差累積而出現嚴重質量下降。

它們往往需要數分鐘的處理時間才能生成短短幾秒鐘的輸出內容。

即便是當下接近實時性能的最快系統,通常也只能分塊生成視頻,這會引入不可避免的延遲,從而無法滿足交互式使用的需求。

誤差積累導致質量迅速下降,從而有效限制了先前自回歸視頻模型的輸出長度。

為了實時生成視頻,LSD必須以「因果方式」運行——每一幀的生成僅基于之前已有的幀。

這種自回歸結構雖然保證了連續性,卻也引入了一個嚴重缺陷:誤差累積。

每一幀都會繼承前一幀的瑕疵,微小的誤差不斷積累,導致質量迅速下降,直至幀內容變得不連貫。

以往的視頻模型要么生成固定且較短長度的視頻,要么采用自回歸生成,但會損失質量,因此僅限于生成較短的輸出。

想要實時生成,LSD需要解決兩個此前在單一系統中尚未被共同解決的挑戰。

無限生成

MirageLSD是首個能夠生成無限長度視頻的視頻生成模型。

模型的自回歸特性使其容易累積誤差,從而限制了輸出的長度。為了實現無限自回歸生成:

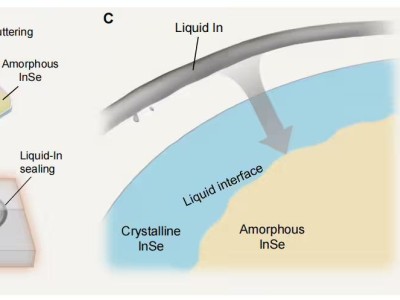

基于DiffusionForcing技術進行構建,該技術支持逐幀去噪。

引入了歷史增強技術,其中模型在經過損壞的歷史幀輸入上進行微調。這使其能夠預測并修正輸入中的偽影,從而增強其對自回歸生成中常見漂移的魯棒性。

這些特點使LSD成為首個能夠無限生成視頻。

實現「實時」性能

實時生成要求每一幀的生成時間不超過40毫秒,以避免被肉眼察覺。通過以下方式實現這一目標:

設計自定義的CUDA超大內核,以最大限度地減少開銷并提高吞吐量。

在快捷蒸餾和模型剪枝的基礎上,減少了每幀所需的計算量。

優化模型架構以與GPU硬件對齊,實現最高效率。

這些技術共同作用,使響應速度比之前的模型提高了16倍,從而實現了每秒24幀的實時視頻生成。

AI視頻仍然缺少交互性

像MovieGen、WAN和Veo這樣的定長模型可以生成高質量的視頻片段,但它們的非因果設計和全片段推理會引入延遲,并且無法實現實時交互或超出預定義長度的擴展。

這意味著AI視頻缺少交互性。

諸如CausVid、LTX和Seeweed-APT之類的自回歸模型通過將每個塊的生成依賴于先前的輸出來生成更長的序列。

雖然這種方法提高了可擴展性,但分塊推理仍然限制了響應速度,并存在誤差累積的問題,限制了生成長度,排除了真正的交互可能性。

可控生成方法,包括ControlNet和基于LoRA的適配器,能夠實現目標編輯和風格遷移,但需要離線微調,不適合實時逐幀提示。

Decart之前的系統Oasis展示了在受限領域內首個實時因果生成。

實時擴散模型MirageLSD將其擴展到開放領域、可提示的視頻,實現零延遲、實時速度和無限穩定性——這是之前的工作未能同時實現的組合。

MirageLSD可以將現實世界中的實物轉化為流媒體中的神話物品——將棍棒打斗變成光劍表演。

擴散模型通過逐步去除隨機噪聲來生成圖像或視頻。

在視頻生成過程中,這通常意味著一次性生成固定長度的片段,這種方法有助于保持時間一致性,但會引入延遲。

一些系統試圖通過按順序生成幀塊來提高靈活性,這種技術被稱為自回歸生成。

然而,每個幀塊仍需完全生成后,模型才能響應新的輸入,從而限制了交互性和實時應用。

LSD采用了一種不同的方法。

它一次生成一幀畫面,使用因果關系的自回歸結構,其中每一幀都依賴于先前生成的幀和用戶提示。

這種方式實現了即時反饋、零延遲交互,并且視頻生成可以持續進行而無需預定義終點。

這種因果反饋循環使LSD能夠保持時間一致性,持續適應運動和內容,并在實時響應用戶提示的同時生成無限視頻序列。

它還能讓LSD即時響應輸入內容——無論是文本提示還是視頻內容的變化——且實現零延遲。

這使得實時編輯和轉換成為可能。

為了實現這一點,Decart使用了擴散強制(Diffusion Forcing)——一種預訓練方法,其中訓練視頻的每一幀都獨立添加噪聲。

這教會了模型在不依賴完整視頻上下文的情況下對單幀進行去噪,從而實現了逐幀生成。

打開LSD的「發動機艙蓋」

LSD的神奇之處在于:能夠在嚴格的延遲預算(低于40毫秒)內獨立生成每一幀,以支持持續的24FPS生成。

這在模型設計和系統執行方面都帶來了重大挑戰。

首先,高質量的擴散模型在計算上非常密集。

它們通常需要大量的參數數量,以及每幀需要多次迭代的去噪步驟。

每一步都需要通過模型進行一次完整的前向傳播,從而導致每幀產生大量的浮點運算(FLOPs)。

其次,與離線生成流水線不同,LSD必須滿足嚴格的每幀延遲約束。

這些約束與現代GPU的架構方式根本相悖:它們優先考慮高吞吐量和大規模批處理執行,而非低延遲的單樣本推理。

挑戰包括內核啟動開銷、在連續層之間重疊計算的機會有限,以及對內存傳輸延遲的敏感性增加,尤其是在多設備設置中。

為了解決這些問題,Decart采用了一個三管齊下的優化策略:

Hopper優化的超大內核:通過利用類似于MegaKernels的若干新興技術,針對NVIDIA Hopper GPU架構優化了模型執行,以在小批量尺寸限制下最小化每層模型的延遲。進一步在這些內核中集成了GPU-GPU通信,以保證設備之間無縫通信,并通過計算操作進行掩蔽。

架構感知剪枝:將模型架構與系統級優化緊密集成,可以在每次模型執行時減少所需的FLOPs數量,同時通過高級技術更好地利用張量核心。這些技術將參數大小調整為特定GPU常量,并使用專用硬件支持進一步挖掘模型權重中的稀疏性。這些剪枝方法旨在根據底層GPU架構調整模型架構,以最大化GPU的利用率,同時通過微調模型使其對移除各種參數具有魯棒性,從而減少整體所需的FLOPs數量。

快捷蒸餾:為了減少生成所需的擴散步驟數量,應用了快捷蒸餾方法,訓練較小的模型以匹配較大教師模型的去噪軌跡。該方法顯著減少了每幀所需的模型評估次數,同時保持了輸出質量與時間一致性。更重要的是,它避免了在長序列中引入新的偽影或漂移。

這些技術共同使LSD能夠將高保真視頻擴散的延遲從每個片段幾秒降低到每幀不到40毫秒,從而實現真正實時、可交互的生成。

參考資料:

https://about.decart.ai/publications/mirage